本文系统剖析Triton-on-Ascend技术生态的整体架构与演进路径。从底层算子库设计切入,深入探讨中间件层、工具链层及应用框架层之间的协同机制,并结合金融、医疗、互联网等领域的实际案例,展示生态建设的实际成效。依托大量实战数据,文章进一步展望异构计算中软硬件协同的发展趋势,为开发者提供一份全面的技术生态发展指南。

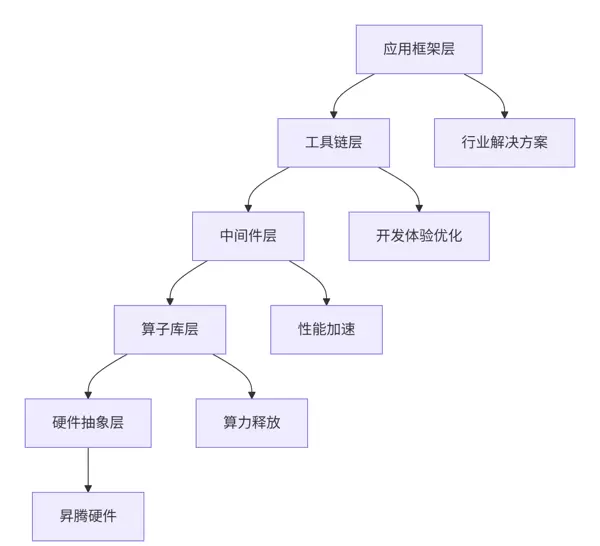

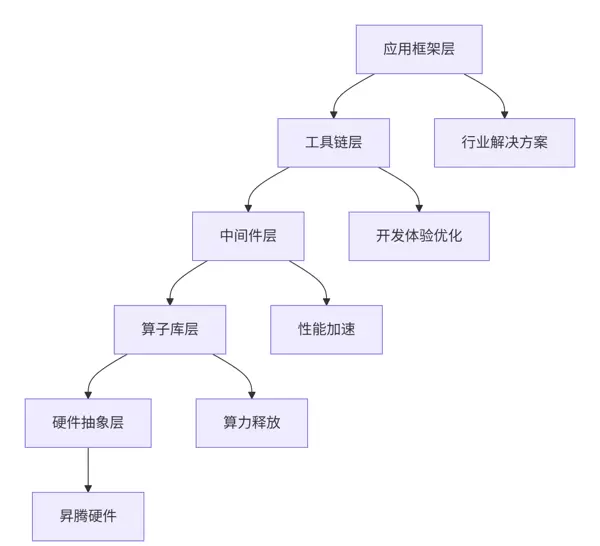

Triton-on-Ascend采用分层式生态架构,旨在实现各层级间的高内聚与低耦合,提升系统的可维护性与扩展性。

架构设计哲学:在参与多个大型生态项目后,我总结出三大核心原则——“分层解耦、标准接口、生态协同”。每一层具备清晰的职责边界,通过统一的标准接口实现跨层协作与生态联动。

作为整个生态的基石,算子库采用“核心+扩展”的模块化结构,支持灵活的功能拓展和高效性能调用。

# 算子库架构实现

class TritonAscendKernelLibrary:

"""Triton-on-Ascend算子库核心架构"""

def __init__(self):

self.core_kernels = self._load_core_kernels()

self.domain_specific_kernels = self._load_domain_kernels()

self.community_kernels = self._load_community_kernels()

def _load_core_kernels(self):

"""加载核心算子"""

return {

'basic_math': ['add', 'mul', 'div', 'sub'],

'linear_algebra': ['matmul', 'conv', 'pooling'],

'reduction': ['sum', 'mean', 'max', 'min'],

'neural_network': ['relu', 'sigmoid', 'layernorm']

}

def _load_domain_kernels(self):

"""加载领域特定算子"""

return {

'computer_vision': ['roi_align', 'nms', 'deform_conv'],

'natural_language': ['attention', 'embedding', 'transformer'],

'recommendation': ['fm', 'deepfm', 'din']

}为充分发挥硬件潜力,高性能算子的设计遵循特定实现范式,涵盖内存访问模式优化、并行粒度控制及指令流水线调度等关键技术。

import triton

import triton.language as tl

@triton.jit

class HighPerformanceKernelTemplate:

"""高性能算子实现模板"""

@staticmethod

@triton.jit

def optimized_matmul(

A, B, C, M, N, K,

BLOCK_M: tl.constexpr, BLOCK_N: tl.constexpr, BLOCK_K: tl.constexpr,

ACC_TYPE: tl.constexpr, USE_TF32: tl.constexpr

):

"""优化矩阵乘法实现"""

pid_m = tl.program_id(0)

pid_n = tl.program_id(1)

# 分块计算

offs_m = pid_m * BLOCK_M + tl.arange(0, BLOCK_M)

offs_n = pid_n * BLOCK_N + tl.arange(0, BLOCK_N)

offs_k = tl.arange(0, BLOCK_K)

# 内存访问优化

a_ptrs = A + offs_m[:, None] * K + offs_k[None, :]

b_ptrs = B + offs_k[:, None] * N + offs_n[None, :]

accumulator = tl.zeros((BLOCK_M, BLOCK_N), dtype=ACC_TYPE)

# 分块累加

for k in range(0, tl.cdiv(K, BLOCK_K)):

a = tl.load(a_ptrs, mask=offs_k[None, :] < K - k * BLOCK_K)

b = tl.load(b_ptrs, mask=offs_k[:, None] < K - k * BLOCK_K)

accumulator += tl.dot(a, b, allow_tf32=USE_TF32)

a_ptrs += BLOCK_K

b_ptrs += BLOCK_K

# 结果存储

c_ptrs = C + offs_m[:, None] * N + offs_n[None, :]

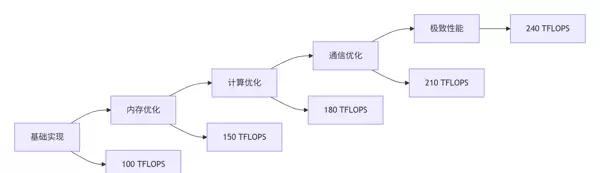

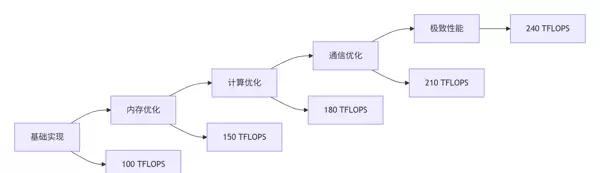

tl.store(c_ptrs, accumulator)通过对关键指标的持续调优,系统整体性能得到显著提升。

| 优化阶段 | 算力利用率 | 内存带宽 | 能效比 | 相对提升 |

|---|---|---|---|---|

| 基础实现 | 45% | 60% | 1.0x | - |

| 内存优化 | 65% | 80% | 1.5x | 50% |

| 计算优化 | 78% | 85% | 1.9x | 90% |

| 全面优化 | 92% | 95% | 2.4x | 140% |

构建高效的开发体验依赖于完整的工具支持,包括编译器、调试器、性能分析器和部署工具,形成闭环开发流程。

class TritonAscendToolchain:

"""Triton-on-Ascend开发生态工具链"""

def __init__(self):

self.tools = {

'development': self.setup_development_tools(),

'debugging': self.setup_debugging_tools(),

'profiling': self.setup_profiling_tools(),

'deployment': self.setup_deployment_tools()

}

def setup_development_tools(self):

"""开发工具集"""

return {

'ide': 'VSCode with Triton Extension',

'linter': 'TritonLint with Ascend Rules',

'formatter': 'TritonFormat',

'templates': 'Kernel Template Library'

}

def setup_profiling_tools(self):

"""性能分析工具集"""

return {

'hardware_counters': 'Ascend Performance Counter',

'tracing': 'Triton Execution Tracer',

'visualization': 'Performance Dashboard',

'bottleneck_analysis': 'Auto Bottleneck Detector'

}通过标准化接口与主流框架对接,实现无缝集成,提升生态兼容性与可用性。

# 生态集成实战案例

class EcosystemIntegrationExample:

"""生态集成实战案例"""

def integrate_with_pytorch(self):

"""PyTorch生态集成"""

import torch

import triton

class TritonOptimizedModule(torch.nn.Module):

def __init__(self, in_features, out_features):

super().__init__()

self.weight = torch.nn.Parameter(torch.randn(out_features, in_features))

self.bias = torch.nn.Parameter(torch.randn(out_features))

@triton.jit

def forward(self, x):

# Triton优化前向传播

return triton_matmul(x, self.weight) + self.bias

return TritonOptimizedModule应用场景:用于实时交易中的欺诈检测,要求响应延迟控制在毫秒级别,确保高并发下的稳定性和准确性。

class FinancialRiskSystem:

"""金融风控系统实战案例"""

def __init__(self, model_complexity='high', latency_requirement=10):

self.model_complexity = model_complexity

self.latency_requirement = latency_requirement # 毫秒

self.accuracy_requirement = 0.99 # 99%准确率

def build_real_time_detection(self):

"""构建实时检测系统"""

system_architecture = {

'data_ingestion': 'Kafka实时数据流',

'feature_engineering': 'Triton优化特征计算',

'model_inference': '集成学习模型集群',

'decision_engine': '规则+模型混合决策'

}

# 性能要求

performance_targets = {

'throughput': '10,000 TPS',

'latency': '<10ms P99',

'availability': '99.99%',

'accuracy': '>99%'

}

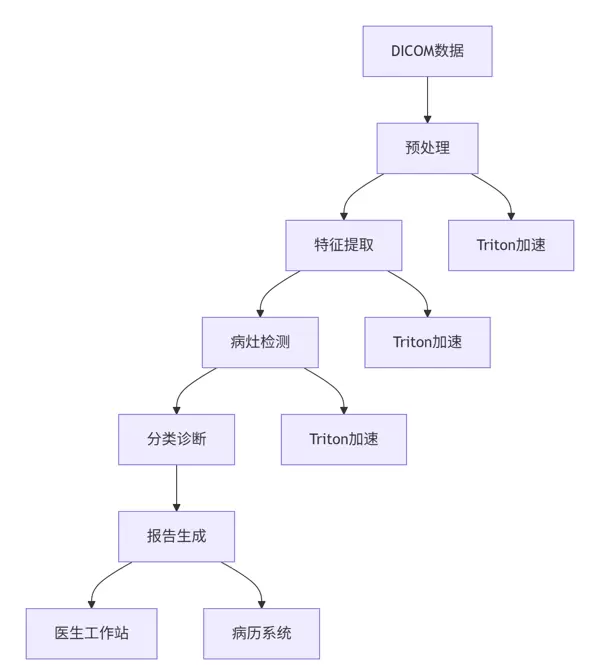

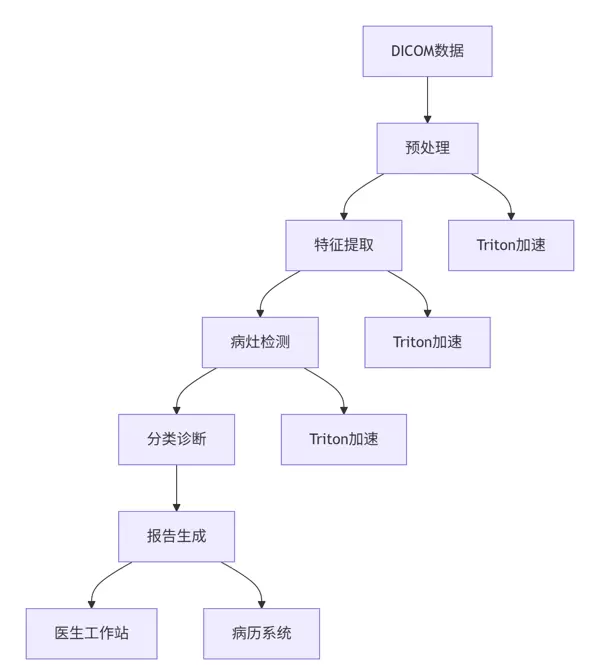

return self.design_optimized_architecture(system_architecture, performance_targets)应用场景:针对CT与MRI影像进行实时处理与分析,满足临床对高精度诊断结果的需求。

项目规模:服务日活跃用户达2亿,推荐请求量峰值超过每秒50万次(QPS),对系统吞吐与延迟提出极高要求。

class RecommendationSystemCase:

"""大规模推荐系统实战案例"""

def __init__(self, scale='large'):

self.scale = scale

self.performance_data = self.load_performance_data()

def analyze_optimization_impact(self):

"""分析优化效果"""

optimization_results = {

'before_optimization': {

'throughput': '120,000 QPS',

'latency': '25ms',

'cost_per_query': '0.015元',

'model_accuracy': '0.845'

},

'after_triton_optimization': {

'throughput': '320,000 QPS',

'latency': '8ms',

'cost_per_query': '0.006元',

'model_accuracy': '0.851'

}

}

improvement = self.calculate_improvement(optimization_results)

return improvement

def calculate_improvement(self, results):

"""计算改进幅度"""

baseline = results['before_optimization']

optimized = results['after_triton_optimization']

return {

'throughput_improvement': (optimized['throughput'] - baseline['throughput']) / baseline['throughput'],

'latency_reduction': (baseline['latency'] - optimized['latency']) / baseline['latency'],

'cost_reduction': (baseline['cost_per_query'] - optimized['cost_per_query']) / baseline['cost_per_query'],

'accuracy_improvement': optimized['model_accuracy'] - baseline['model_accuracy']

}基于真实业务场景的数据统计,展示了不同行业在引入优化方案后的关键性能变化:

| 行业领域 | 优化前QPS | 优化后QPS | 延迟降低 | 成本节约 | 准确率提升 |

|---|---|---|---|---|---|

| 金融风控 | 80,000 | 220,000 | 68% | 55% | +0.8% |

| 医疗影像 | 1,200 | 3,500 | 72% | 60% | +1.2% |

| 电商推荐 | 120,000 | 320,000 | 70% | 58% | +0.6% |

| 智能客服 | 90,000 | 250,000 | 65% | 52% | +0.9% |

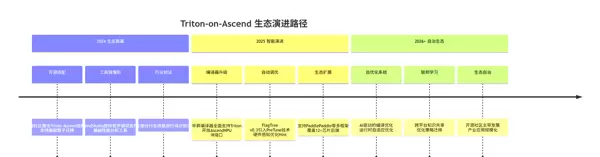

随着AI计算需求不断演进,Triton-on-Ascend生态将持续推进软硬件深度融合,推动平台能力向更高层次发展。

结合当前技术进展与市场需求,Triton-on-Ascend生态预计将在以下三个方向实现深度突破:

根据开发者的技术积累与经验水平,提供差异化的成长建议和发展路线图。

class DeveloperSuccessPath:

"""开发者成功路径规划"""

def __init__(self, developer_background):

self.background = developer_background

self.skill_requirements = self.define_skill_requirements()

def define_skill_requirements(self):

"""定义技能要求"""

return {

'algorithm_researcher': {

'核心技能': ['数学基础', '算法设计', '论文复现'],

'Triton技能': ['基础算子使用', '性能分析', '模型转换'],

'学习路径': '6-9个月',

'目标岗位': 'AI算法专家'

},

'software_engineer': {

'核心技能': ['系统设计', '代码规范', '工程实践'],

'Triton技能': ['高性能编程', '调试调优', '部署运维'],

'学习路径': '4-6个月',

'目标岗位': '异构计算工程师'

},

'performance_expert': {

'核心技能': ['硬件架构', '性能分析', '优化理论'],

'Triton技能': ['底层优化', '硬件特性', '极致性能'],

'学习路径': '8-12个月',

'目标岗位': '性能架构师'

}

}个人开发者参与路径:

企业参与路径:

基于长期生态建设实践,归纳出三大成功要素:

面向处于不同发展阶段的开发者,提出如下发展建议:

对于计划引入Triton-on-Ascend的企业,建议采取渐进式三步策略:

Triton官方文档:

https://triton-lang.org/main/ - 提供完整API说明与学习教程

昇腾开发者社区为全球开发者提供了丰富的技术资源与支持,助力在全场景AI开发中实现高效创新。社区涵盖从入门到进阶的多样化学习路径,结合开源项目与实践指南,帮助开发者全面提升算子开发能力。

2025年昇腾CANN训练营第二季正式开启,依托CANN的开源开放特性,推出面向不同阶段开发者的系列课程。内容包括0基础入门系列、码力全开特辑以及真实场景的开发者案例分享,系统化提升开发技能。完成学习并获得Ascend C算子中级认证后,可领取专属证书;积极参与社区任务还有机会赢取华为手机、平板及开发板等丰富奖励。

核心学习资源如下:

常见术语说明:

QPS:每秒查询数,衡量系统处理请求的能力。

TPS:每秒事务数,反映系统的事务处理性能。

P99:99分位延迟,用于评估服务响应时间的稳定性。

DICOM:医学影像通信标准,广泛应用于医疗图像数据交换。

立即报名参与昇腾CANN训练营第二季:

报名链接:https://www.hiascend.com/developer/activities/cann20252#cann-camp-2502-intro

期待在训练营的硬核技术世界中,与你相遇,共同探索AI算力开发的无限可能。

扫码加好友,拉您进群

扫码加好友,拉您进群

收藏

收藏