最初的支持向量机是由 Vladimir N. Vapnik和Alexey Ya. Chervonenkis在1963年发明的。支持向量机是有监督的机器学习,被广泛应用于处理分类问题或者回归问题,SVC是Support vector classification和SVR是Support vector regression。分类问题如处理离散标签的分类,连续问题如房价预测。

支持向量机以分类而闻名,以下简要介绍支持向量机的分类模型。

首先需要知道的概念是决策边界,即超平面。支持向量机的目标是找到最佳超平面,将数据集分为两个类别或者组。

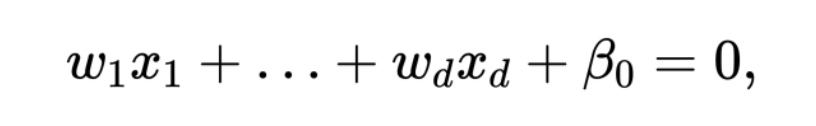

根据投入的特征个数,决策边界可能是一条直线,或者是一个超平面。你可以这样想:一个有n维特征的标签,在n维空间中都有一个位置,而它的超平面就是在n-1维的空间中。 超平面的数学公式如下:

支持向量:

支持向量就是离超平面最近的点。这些点会改变分离超平面(separating hyperplane)的位置。因此,支持向量是很重要的点,用于定义最佳超平面。

硬边距: 有很多线可以用于区分类别,但是哪一条线是最好的? 超平面和最近点间的距离为支持向量机边际。目标是选取最大的支持向量机边际。支持向量机算法通过最大化支持向量机边际最大化,来选择最佳超平面。

综上所述,支持向量机通过挑选不同类别间的支持向量距离最大化的距离,来选择决策边界。如果决策边界和支持向量离的很近,那么决策边界会对噪音敏感。

扫码加好友,拉您进群

扫码加好友,拉您进群