文章摘要

沙特阿卜杜拉国王科技大学与Meta AI研究小组提出了Vgent框架,通过建立视频语义图谱和结构化推理机制,大幅提升了大型视频语言模型在长视频理解任务中的效能,在MLVU基准测试中取得了3.0%-5.4%的性能提升。

原文PDF - 下载链接

引言:长视频理解的技术挑战

随着多模态大语言模型(MLLMs)在视觉理解领域迅速发展,大型视频语言模型(LVLMs)在视频理解任务中展现了巨大的潜力。然而,处理和推断长时间视频内容仍是一个重大挑战——例如,一段30分钟的视频可能包含超过200K个标记,远远超出大多数模型的上下文限制。

当前的解决方案主要依赖稀疏帧采样或标记压缩技术,但这些方法不可避免地会导致视觉信息的损失,影响细粒度时间理解和连贯推理的能力。尽管检索增强生成(RAG)技术在处理大语言模型的长上下文方面表现出色,但在长视频应用中却面临时间依赖关系断裂和不相关信息干扰等问题。

Vgent框架:创新的图谱化解决方案

核心创新点

沙特阿卜杜拉国王科技大学与Meta AI的研究人员提出了Vgent框架,这是一个基于图的新检索推理增强生成框架,旨在加强LVLMs的长视频理解能力。

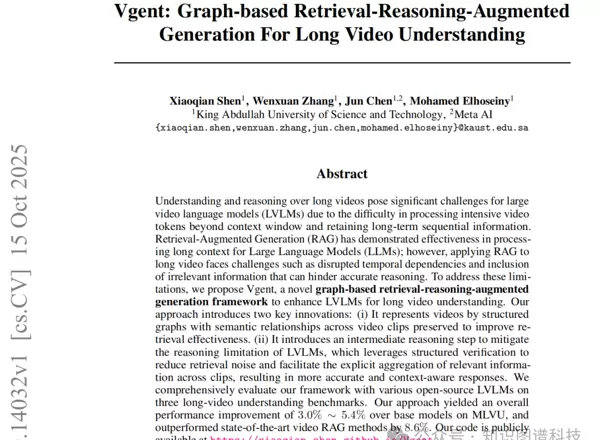

该框架的两个主要创新包括:

- 结构化图表示:通过构建保持视频片段间语义关联的结构化图谱来表示视频,提高检索效率。

- 中间推理步骤:引入结构化验证机制以减少检索噪声,促进跨片段相关信息的显式聚合,生成更加精确和上下文感知的回答。

[Figure 1框架总体概览图,展示基于图的检索推理增强生成框架]

技术架构深度解析

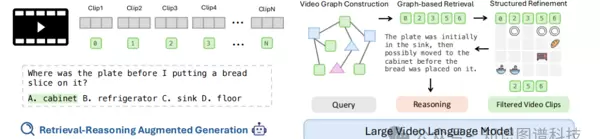

Vgent框架采用了四阶段流水线设计,如下图所示:

[Figure 2:完整的技术流水线图]

阶段一:离线视频图谱构建

首先,系统将长视频V划分为包含K帧(K=64)的短视频片段序列{V?, V?, ..., V?F/K?}。对于每个视频片段,利用LVLM从口语内容(字幕)C?和视频片段V?中抽取关键语义实体:

code

{(e??,?t??), (e??,?t??), ...} ← LVLM(C?, V?)

实体集合记为E? = {e??, e??, ...},对应描述集合记为T? = {t??, t??, ...}。

实体合并与节点连接 是图构建的重要环节。由于LVLM独立处理视频片段,系统需要识别并统一跨片段语义等价的实体。具体来说,对于新提取的实体-描述对(e??, t??),系统计算其与全局实体集合U中实体描述的相似度分数:

code

s*?=?max_{u∈U} sim(t??, t?)

u* = argmax_{u∈U} sim(t??, t?)

如果相似度分数 > τ(τ=0.7),则实体e??被认为与现有实体语义等价并合并;反之,则作为独立实体加入U。

阶段二:基于图的检索

- 关键词提取:系统首先从查询Q中抽取关键语义元素K,以避免直接基于原始查询进行检索可能引起的上下文不足问题。

- 图基检索:对于每个关键词k∈K和每个实体u∈U,计算相似度分数sim(k, t?)。如果sim(k, t?) > θ(θ=0.5),则将与实体u相关的所有节点纳入目标检索节点集R:

code

R?= ?_{u∈U,k∈K} {v∈V | u∈U(v), sim(k,?t?) > θ}

获得检索节点集R后,系统根据查询关键词与每个节点的实体、文本描述和字幕的相似度对节点重新排序,最终选取Top-N(N=20)个具有最高平均相似度分数的节点。

阶段三:结构化推理

- 结构化查询细化:研究团队发现,在大约40%的失败案例中,正确的片段确实被成功检索到,但模型仍然生成错误响应。为解决此问题,系统采取分而治之策略,通过结构化查询验证来优化检索结果。

具体而言,系统提示LVLM基于原始查询Q和提取的关键词K生成结构化子查询Q。这些子查询专注于验证相关实体的存在或量化其出现次数,期望答案为二元(是/否)或数值。

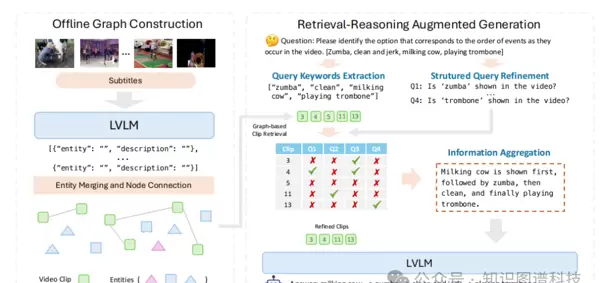

[Figure 3:结构化子查询示例图]

经过结构化验证后,细化的片段集R'可表示为:

code

R'?=?{v? ∈ R | ?q? ∈ Q, f(v?, q?) > 0}

其中f(v?, q?)表示检索片段v?对子查询q?的响应。系统在细化后最多保留r=5个片段。

- 信息聚合:系统让LVLM汇总和总结来自结构化查询的所有有用信息及其对应的每个视频片段结果,提供丰富的辅助上下文以增强最终推理。

阶段四:多模态增强生成

系统将中间推理结果和过滤后的视频片段作为多模态上下文输入到LVLM中生成最终响应。这种丰富的输入使模型能够同时利用结构化推理和相关视觉信息,生成更准确且上下文相关的最终答案。

实验评估与性能表现

实验设置

研究团队在七个不同规模(2B到7B)的LVLM上评估了框架性能,包括InternVL2.5、Qwen2、Qwen2.5-VL、LongVU和LLaVA-Video等开源模型。

评估使用了三个长视频理解基准:

- Video-MME:包含从11秒到1小时的不同长度视频子集

- MLVU:视频长度从3分钟到2小时,平均约为12分钟

- LongVideoBench (LVB):专注于需要分析长帧序列的推理任务

主要实验结果

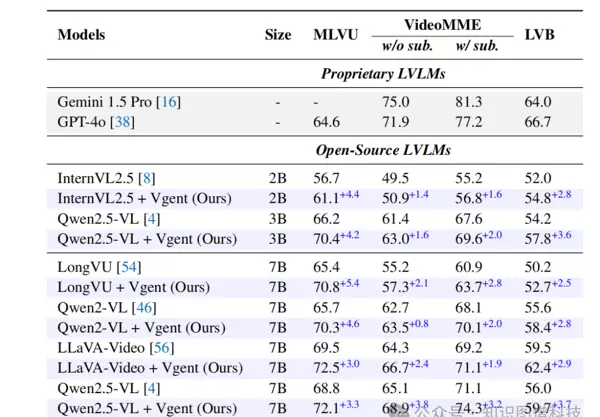

[Table 1:与LVLM性能对比表]

与LVLM比较:实验数据表明,Vgent框架在所有模型上均实现了明显提升:

在MLVU基准上,该框架将LongVU性能提升了5.4%,Qwen2.5VL (7B)提升了3.3%

特别指出,当应用于Qwen2.5VL (3B)时,Vgent达到了70.4%的准确率,超过了更大规模的7B版本,并将基本模型性能提高了4.2%

在VideoMME基准上,该框架在各种视频长度上的表现均优于基本模型,平均性能提升4.2%

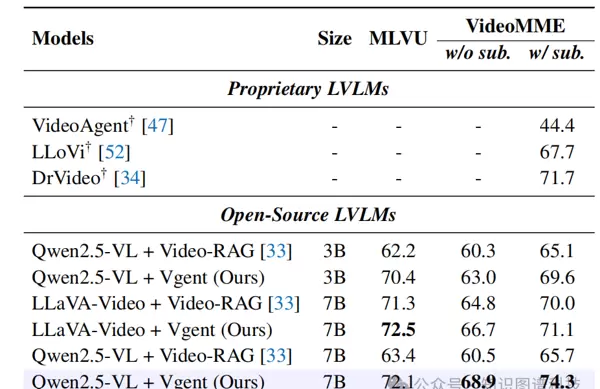

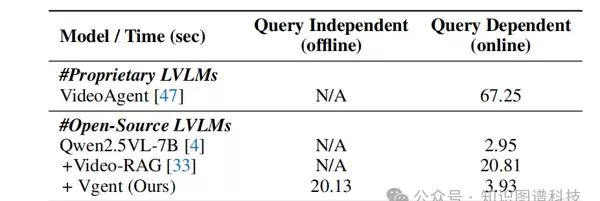

[Table 2:RAG方法对比表]

与最先进的RAG方法比较:

该框架在三种不同的LVLM基础模型上持续优于RAG基线Video-RAG

与高度依赖封闭源代码API的专有RAG方法相比,Vgent提供了更加灵活高效的长视频理解解决方案

总体而言,该框架超越了现有的基于RAG的视频理解工作8.6%

消融实验分析

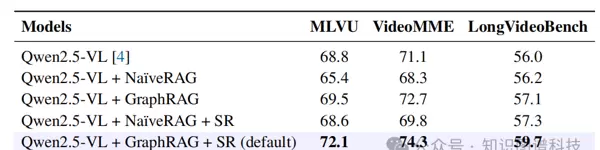

[Table 3:消融实验结果表]

Na?veRAG与GraphRAG的对比:集成GraphRAG比Na?veRAG平均提升了2.9%,尤其在MLVU上显著提升了4.1%。这归因于Na?veRAG难以处理涉及跨多个片段时序推理的复杂查询,而GraphRAG通过图形表示有效地保持了片段间的语义联系。

结构化推理(SR)的效果:通过结构化查询的中间推理细化检索节点,在MLVU上额外提升了2.6%,在VideoMME上提升了1.6%,总体平均提升了3.4%。

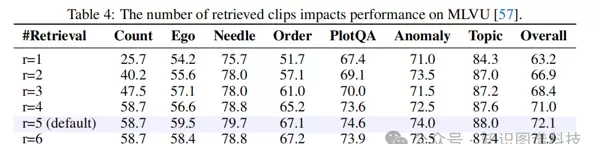

检索数量的影响:

[Table 4:检索片段数量影响分析表]

研究表明,增加检索片段数量持续改善了性能,尤其是在需要多片段推理的任务中,在r=5时达到了最佳性能。

推理时间分析

[Table 5:推理时间分析表]

该框架在计算效率方面表现出色:

离线图构建需要20.13秒,但这是一次性的查询无关过程

在线检索、推理和生成过程每分钟视频仅需3.93秒

在多问题场景中(例如,VideoMME每个视频三个问题),相比Video-RAG实现了1.73倍的速度提升

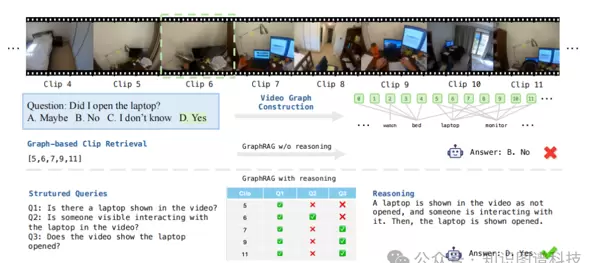

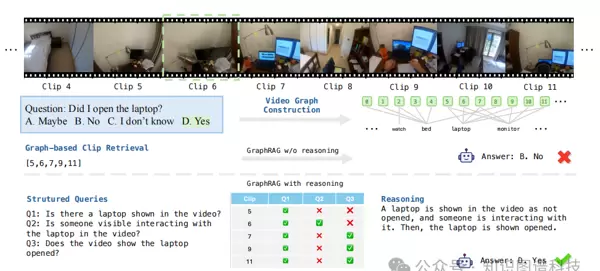

定性分析案例

[Figure 3:定性分析示例]

图3展示了一个典型实例:尽管基于图的检索系统能够识别包含笔记本电脑的相关节点,但由于来自多个片段的难负样本的干扰,模型最初给出了错误答案。然而,通过中间推理步骤验证每个检索节点的结构化子查询,系统能够正确推断出笔记本电脑被打开,克服了难负样本的干扰。

技术优势与创新价值

相比现有方法的优势

保持时序连贯性:与将长视频分割成独立文档的传统方法不同,Vgent通过图结构保持了实体和时序依赖关系

自包含设计:与依赖专有大型语言模型如GPT-4的方法相比,Vgent专门针对开源LVLM设计,更具灵活性和成本效益

查询无关图构建:图构建过程离线执行且与查询无关,一旦构建即可用于同一视频的多个问题,无需重新处理视频

结构化噪音减少:通过结构化推理步骤系统地过滤无关片段,有效减少了信息过载问题

应用场景与商业价值

该技术在多个领域具有广泛的应用前景:

网络内容分析:自动理解和标注长时间在线视频内容

生活记录系统:智能检索和分析个人或企业的长时间视频记录

流媒体服务:提高视频推荐系统的内容理解精度

安防监控:长时间监控视频的异常检测和事件分析

局限性与未来发展

尽管Vgent框架在长视频理解方面取得了显著进展,但仍存在一些限制:

图构建开销:虽然是离线过程,但对于大规模视频数据集,图构建仍需要大量的计算资源

实体识别准确性:框架性能部分依赖于LVLM的实体提取能力,在复杂场景中可能存在识别错误

跨模态对齐:视觉实体与文本描述的对齐仍有改进空间

未来研究方向可能包括:优化图构建算法以提高效率,增强跨模态实体对齐技术,扩展到更多的视频理解任务

结论与展望

Vgent框架通过创新的图谱化表示和结构化推理机制,为长视频理解领域带来了重要的突破。其在保持时序关系、减少检索噪音、提高推理准确性等方面的技术创新,不仅在学术基准测试中获得了显著的性能提升,也为实际应用场景提供了可行的解决方案。

该工作为更准确和上下文感知的长视频检索推理系统铺平了道路,标志着多模态大型语言模型在视频理解领域的重大进展。随着技术的不断完善,预计将在智能视频分析、内容理解等领域产生广泛的商业价值和社会影响。

标签 #GraphRAG #视频理解 #大模型 #多模态 #LLM #检索增强生成

注:本文基于沙特阿卜杜拉国王科技大学和Meta AI研究团队的最新研究成果编译整理,详细技术实现请参考原论文。

欢迎加入「知识图谱增强大模型产学研」知识星球,获取最新的产学研相关"知识图谱+大模型"相关论文、政府企业落地案例、避坑指南、电子书、文章等,行业重点是医疗护理、医药大健康、工业能源制造领域,也会跟踪AI4S科学研究相关内容,以及Palantir、OpenAI、微软、Writer、Glean、OpenEvidence等相关公司的进展。

扫码加好友,拉您进群

扫码加好友,拉您进群