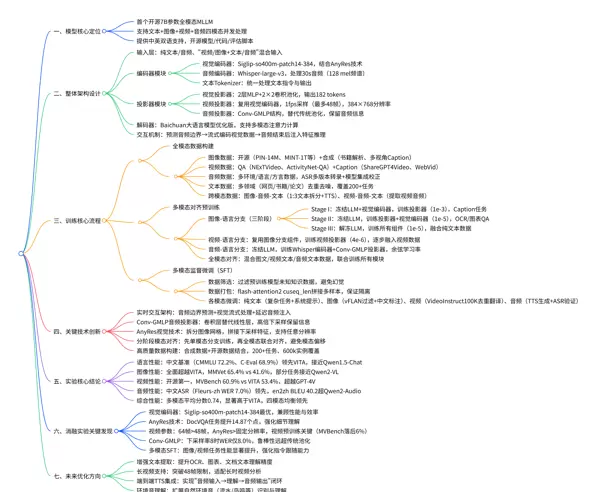

一、背景与核心贡献

1.1 核心定位

Baichuan-Omni 的核心目标在于构建一个开源、高效且支持多模态实时交互的基础大模型,旨在打破如 GPT-4o 等闭源模型在全模态领域的技术垄断。通过提供可复现、可扩展的技术方案,该模型为开源社区树立了一个高性能的全模态语言模型基线。

1.2 三大核心创新点

- 全模态覆盖与完全开源:作为首个开源的 7B 参数级别、支持文本、图像、视频、音频四模态并发处理的多模态大语言模型(MLLM),Baichuan-Omni 提供中英双语能力,并公开模型权重、训练代码及评估脚本。

- 创新性实时交互架构:通过预测音频输入边界、对视觉数据进行流式编码,并延迟注入音频特征,实现音视频流式输入下的低延迟推理,显著提升人机交互的自然流畅度。

- 端到端训练框架设计:提出“全模态数据构建 → 多模态对齐预训练 → 多任务微调”的完整训练流程,在涵盖 200+ 任务、60万实例的数据集上完成训练,确保强大的跨模态理解与指令遵循能力。

二、全模态 LLM 面临的技术挑战与应对策略

2.1 技术背景与行业现状

当前多模态大模型正处于从单模态向统一全模态演进的关键阶段:

- MLLM 的发展历程:早期模型如 LLaMA 和 Baichuan 仅限于文本处理;后续发展出图文模型(如 Qwen2-VL)和音文模型(如 Qwen-Audio),但尚未实现多种感官信息的深度融合。

- 闭源与开源之间的差距明显:

- GPT-4o、Gemini 1.5 Pro 等闭源系统已实现文本、图像、视频、音频的无缝融合与自然对话交互;

- 而大多数开源 MLLM 仍局限于两模态(如图文或音文),缺乏统一建模能力,且难以支持流式输入,响应延迟高,实用性受限。

Baichuan-Omni 正是针对上述问题而设计——以“全模态覆盖 + 实时交互”为核心突破方向,采用 7B 规模的轻量化结构,在性能与部署成本之间取得平衡,致力于成为开源生态中的标杆级全模态基础模型。

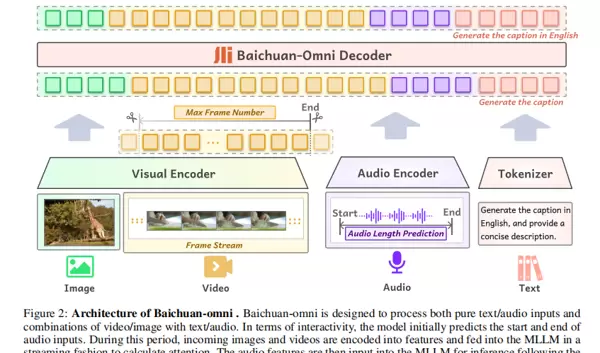

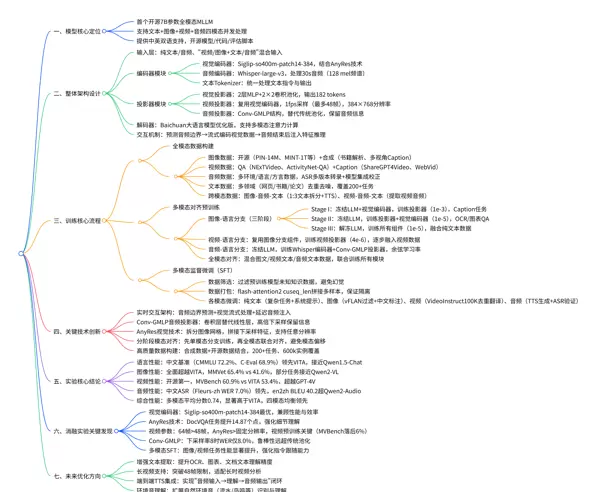

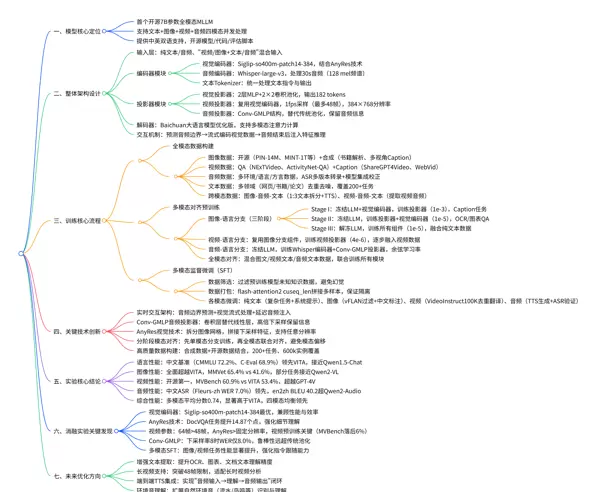

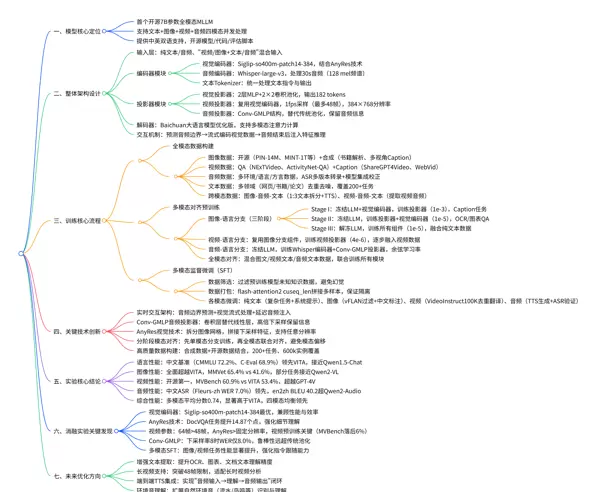

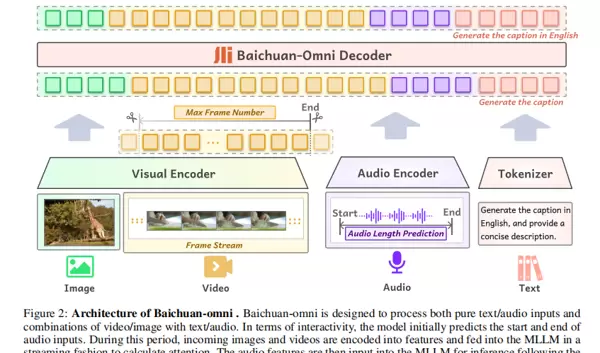

2.2 模型整体架构概览

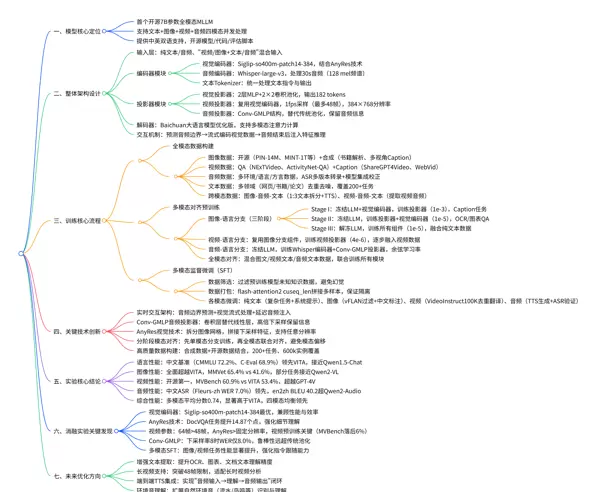

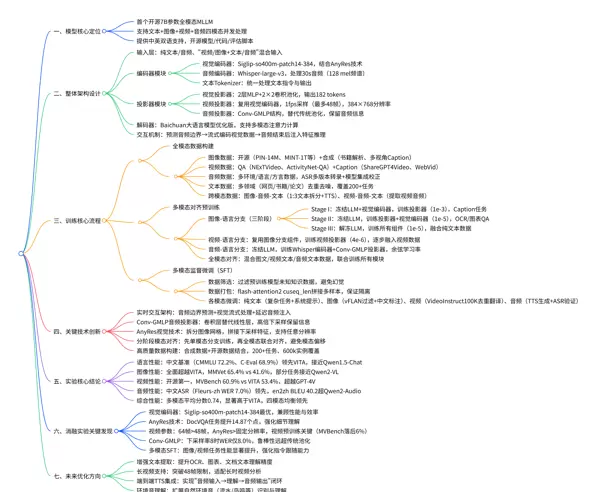

Baichuan-Omni 的架构围绕“多模态统一编码”与“流式交互机制”展开,其结构如图 2 所示:

关键组件解析

- 输入层:支持纯文本或纯音频输入,也可接受“图像/视频 + 文本/音频”的混合输入形式,具备高度灵活的接口适配能力。

- 编码器模块:

- 视觉编码器:基于 Siglip-384px 模型,结合 AnyRes 技术,支持任意分辨率的图像与视频帧输入;

- 音频编码器:采用 Whisper-large-v3,输出 1280 维高维特征向量;

- 文本 Tokenizer:统一处理所有文本内容,包括指令解析与生成输出。

- 投影器(Projector):

- 视觉投影器:使用 2 层 MLP 加上 2×2 卷积池化操作,将图像特征映射至 LLM 嵌入空间;

- 视频投影器:在图像投影器基础上扩展,用于处理连续帧序列的时间特征;

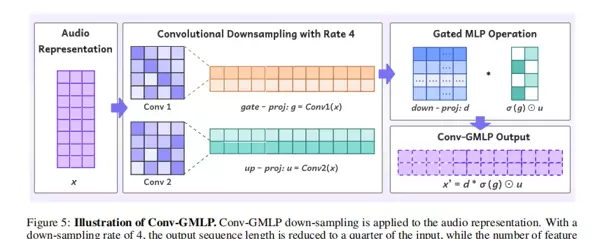

- 音频投影器:引入创新的 Conv-GMLP 结构,替代传统池化方式,有效保留音频中的细节信息。

- 解码器(Baichuan-Omni Decoder):基于 Baichuan 系列大语言模型优化而来,支持多模态特征的联合注意力计算与上下文感知的内容生成。

- 交互机制:系统首先预测音频输入的起止时间边界,在此期间并行流式处理视觉数据并提前计算注意力;待音频输入结束后再注入音频特征,完成最终推理过程,从而实现真正的音视频流式响应。

三、相关工作:全模态大模型的技术演进路径

3.1 当前主流技术路线及其局限性

| 模型类型 |

核心能力 |

代表模型 |

主要局限 |

| 纯文本 LLM |

自然语言理解与生成 |

LLaMA、Baichuan、Qwen1.5 |

不具备视觉与音频理解能力 |

| 视觉 - 语言模型(VLMs) |

图文对齐与视觉问答 |

LLaVA、Qwen2-VL、InternVL |

仅支持图文模态,无法处理音视频 |

| 音频 - 语言模型(ALMs) |

语音识别与音频问答 |

Qwen-Audio、SALMONN |

无视觉理解功能,模态单一 |

| 闭源全模态模型 |

多模态深度融合与交互 |

GPT-4o、Gemini 1.5 Pro |

不开源,限制二次开发与研究复现 |

| 开源全模态模型 |

多模态交互能力 |

VITA |

模态对齐精度较低,中文支持弱,交互体验差 |

3.2 Baichuan-Omni 的差异化优势

相较于现有各类模型,Baichuan-Omni 在以下方面展现出显著优势:

- 首次在 7B 小参数量级实现四模态并发处理(文本、图像、视频、音频),填补了开源领域高性能全模态模型的空白;

- 通过流式视觉编码 + 延迟音频注入机制,实现接近实时的人机交互体验,优于传统“等待全部输入完成”的静态推理模式;

- 具备完整的中英双语支持能力,尤其在中文场景下表现优异,弥补了多数国际开源模型在中文理解上的不足;

- 提供从数据、训练到评估的全流程开源资源,极大降低了研究者与开发者的技术门槛。

突破模态边界:首次在开源大模型中实现“文本、图像、视频、音频”四模态统一建模,构建真正意义上的全模态智能系统;

强化中文理解能力:针对中文使用场景深度优化数据构成与训练策略,在主流中文评测基准(如 CMMLU、C-Eval)上显著超越现有开源模型;

提升实时交互体验:采用创新的流式处理架构,有效解决传统开源模型在输入方式上的“非流式”瓶颈,实现更自然、低延迟的人机交互。

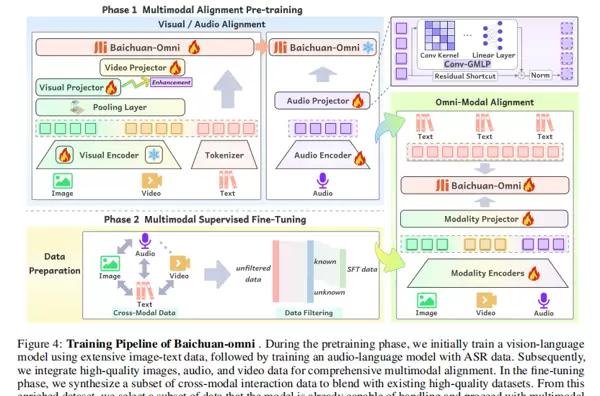

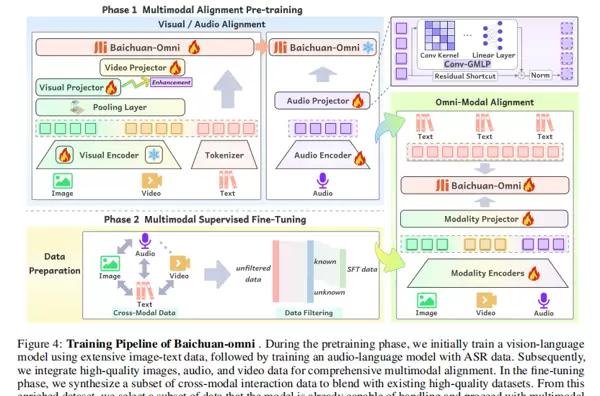

四、训练框架:全模态能力的技术实现路径

Baichuan-Omni 的模型训练流程由三大核心阶段构成:

高质量多模态数据构建 → 多模态语义对齐预训练 → 多任务监督微调(SFT),

形成完整的端到端训练闭环体系。

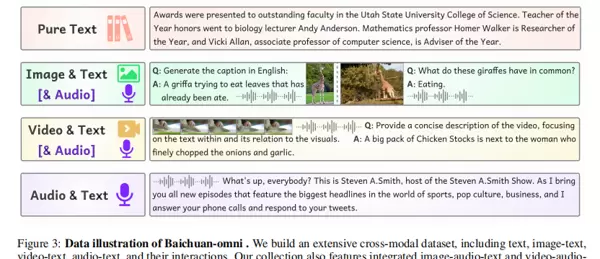

4.1 高质量全模态数据集构建

作为多模态模型的基础支撑,Baichuan-Omni 构建了覆盖“单模态输入”到“跨模态协同”的大规模、高多样性数据集,总计包含 600,000 条样本,涵盖超过 200 种任务类型。整体结构如下:

4.1.1 图像相关数据处理

数据分类:划分为图像描述(Caption)、图文交错内容、OCR 文本识别、图表解析四大类别;

来源说明:

- 公开数据集:第一阶段(图像-语言预训练)使用 PIN-14M、MINT-1T、LAION5B 等;第二、三阶段(微调阶段)引入 Cauldron、Monkey、ArxivQA 等高质量资源;

- 合成数据:从书籍和学术论文中自动抽取并生成图文交错结构、OCR 内容及专业图表数据(聚焦知识密集型领域),并通过专用模型生成多视角、高准确性的图像描述;

处理流程:经历数据清洗、采样均衡化以及格式标准化三个关键步骤,确保输入质量一致。

4.1.2 视频数据整合

任务覆盖:包括视频分类、动作识别、时序定位、视频问答(Video QA)以及视频描述生成(Video Captioning)等;

数据来源:

- 问答类数据:来自 NExTVideo 和 ActivityNet-QA 的训练集部分;

- 描述类数据:采用 ShareGPT4Video(由 GPT-4 自动生成)、WebVid,以及通过 GPT-4o 对 YouTube 视频生成描述文本的数据;

采样策略:依据各数据集规模设定采样权重,保障不同类型视频、任务类型和应用领域的分布均衡性。

4.1.3 音频数据建设

多样性设计:涵盖多种录音环境、中英文语言、不同口音与方言,并包含人声、背景音效及混合音频场景;

处理流水线:依次进行说话人分离→方言识别→口音判断→音效检测→音频质量评估→最终筛选;

音文对齐机制:结合自研 ASR 系统与开源模型(如 Whisper-large-v3)生成多个转录版本,利用模型集成技术进行错误校正,显著提升语音与文本之间的对齐精度。

4.1.4 文本数据组织

来源范围:广泛采集网页内容、出版书籍、学术论文、编程代码等多领域文本资源;

处理标准:

- 多样性保障:覆盖广泛主题与语言风格;

- 质量控制:实施去重、去噪处理,增强知识密度;

支持任务:涵盖知识问答、数学逻辑推理、代码生成、创意写作以及安全性相关的指令理解任务。

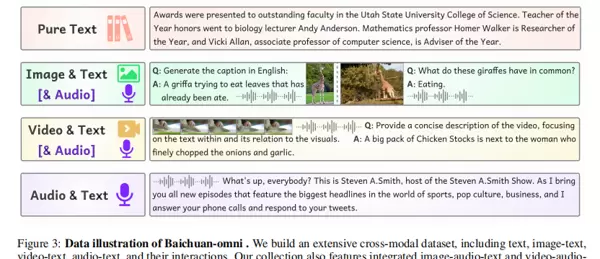

4.1.5 跨模态交互数据构造

为加强模型在复杂情境下的多模态协同理解能力,特别构建了融合“图像-音频-文本”与“视频-音频-文本”的混合数据集:

- 图像-音频-文本组合:将原始文本按 1:3 比例拆分,其中 1/4 文本通过 TTS 技术(支持 44 种音色)转化为语音,设计任务提示如“听取音频描述后结合图像信息补全文本”,要求模型预测剩余 3/4 的文本内容;

- 视频-音频-文本组合:直接提取视频中的原生音频流作为跨模态元素,结合视频帧画面与文本指令共同构建训练任务。

4.2 多模态语义对齐预训练

该阶段的核心目标是使大语言模型能够理解视觉(图像/视频)与听觉(音频)信号,达成不同模态间的深层语义对齐。训练分为三个单模态分支独立训练 + 全模态联合优化两个层次,整体流程如图所示:

4.2.1 图像-语言分支(三阶段渐进式训练)

视觉编码器:采用 Siglip-so400m-patch14-384(参数量 4.28 亿,输入分辨率 384×384),结合 AnyRes 技术实现任意尺寸图像输入——通过网格划分图像,并拼接下采样特征以保留全局上下文信息;

视觉投影器:由两层 MLP 和 2×2 卷积池化组成,输出固定长度为 182 的 token 序列;

训练细节:

| 训练阶段 |

训练目标 |

冻结策略 |

学习率 |

训练数据 |

| Stage I |

图像与文本初始对齐 |

冻结 LLM 与视觉编码器,仅训练投影器 |

1e-3 |

大规模图像-文本对(Caption 任务为主) |

| Stage II |

强化 OCR 与图表理解能力 |

冻结 LLM,训练投影器与视觉编码器 |

1e-5 |

VQA 数据、13万+ OCR/图表问答、图文交错数据 |

| Stage III |

提升图文协同响应性能 |

解冻 LLM,联合训练所有模块 |

1e-5 |

VQA、图像描述、图文交错、纯文本任务混合训练 |

4.2.2 视频-语言分支

基础架构复用:沿用图像-语言分支中的 Siglip-384px 视觉编码器和 LLM 主干网络,仅新增并训练视频专用投影器;

视频处理方案:

- 帧采样:以 1fps 进行抽帧,单个视频最多保留 48 帧;

- 分辨率调整:统一调整为 384×768,兼顾视觉质量和计算效率;

- 特征压缩:在投影器前加入 2×2 卷积层,控制输出 token 数量在 182 至 546 之间;

训练策略:

- 先利用图像-文本数据夯实视觉理解基础;

- 再逐步引入图文混合数据与视频-文本对,防止因直接训练导致的模态间表征偏移问题。

4.2.3 音频-语言分支

基于专用音频编码器实现声音信号到语义空间的映射,配合语言模型完成音文联合建模,具体方法详见后续章节。

采用 Whisper-large-v3 模型处理 30 秒音频(128 mel 频谱),输出 1280 维特征向量,作为音频编码的基础表示。

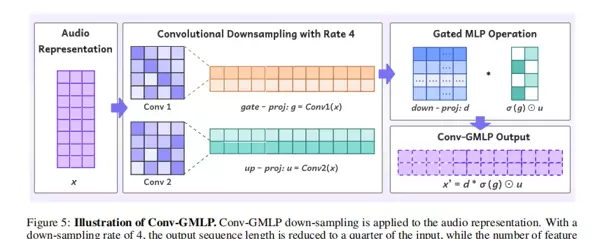

音频投影器设计(核心创新点)

引入 Conv-GMLP 结构替代传统池化操作,有效缓解高倍率下采样过程中造成的音频信息丢失问题:

- 结构设计:受门控 MLP 启发,使用卷积层取代线性层。整体包含两个卷积层(实现 n 倍下采样)并引入残差连接;在序列长度压缩的同时扩展通道维度(例如当 n=4 时,序列缩减为原来的 1/4,通道数则扩大至 4 倍);

- 优势体现:即使在较高下采样倍率(如 n=8)下,仍能较好保留关键语音特征,显著增强自动语音识别(ASR)与音频语义理解的鲁棒性。

训练策略

固定大语言模型(LLM)参数,仅对音频编码器与投影模块进行训练;输入数据为长音频-文本序列(最长支持 4K tokens),优化过程采用余弦学习率调度器以提升收敛稳定性。

4.2.4 全模态对齐(Omni-Alignment)

在完成图像、视频、音频三个单模态分支的独立训练后,进入联合训练阶段。通过混合数据集(涵盖图像-文本、视频-文本、音频-文本)输入,驱动文本、图像、视频、音频四模态之间的全局语义对齐,为后续跨模态交互能力奠定基础。

4.3 多模态监督微调(SFT)

该阶段的核心目标在于强化模型的指令遵循能力,并使其适配复杂的多模态任务场景。

4.3.1 数据筛选与预处理

- 知识覆盖过滤:依据预训练模型的知识边界,剔除涉及“未知领域”的样本,降低生成幻觉的风险;

- 任务多样性保障:覆盖超过 200 类任务类型,包括纯文本、音频内容、图文结合、视频文本及图像-音频联动等多模态交互数据;

- 训练效率优化:利用 flash-attention2 的 cuseq_len 功能实现多样本拼接,在批量训练中保持各样本间的隔离性,从而提升训练速度和内存使用效率。

4.3.2 各模态微调数据细节

纯文本数据

包含多步骤推理任务与系统级提示指令数据,重点提升模型在复杂逻辑推导与指令解析方面的能力。

图像理解数据

- 基础数据集:vFLAN(经损失过滤、中英翻译与人工重标注)、synthdog-en/zh、手写体 OCR、街景文字识别等;

- 优化策略:ImageInWords 数据集中要求精确命名实体(如“萨摩耶犬”而非泛称“狗”);同时构建融合图像信息的数学推理题,增强视觉-语言联合推理能力。

视频理解数据

基于 VideoInstruct100K 构建,对原始指令执行语义去重与中文翻译处理,进一步丰富任务类型的多样性。

音频理解数据

- 合成音频:从文本、图文或视频数据中提取提示词,通过 TTS 技术生成对应语音,并借助 ASR 系统验证转录准确性;

- 真实录音:包含方言、口音以及背景噪声干扰的人类实际录制音频,提升模型在真实环境下的适应性;

- 专项训练集:构建专用 ASR 数据集(整合开源资源与内部日志),筛选高难度样本用于针对性强化训练。

五、实验结果:全模态性能全面领先

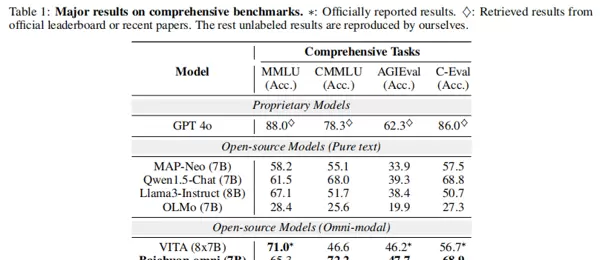

论文在语言、图像、视频、音频四大模态的标准基准上开展了零样本评估,对比对象包括闭源模型(GPT-4o、Gemini 1.5 Pro)与主流开源模型(VITA、Qwen2-VL 等)。结果显示,Baichuan-Omni 在多个指标上优于现有开源全模态模型,部分任务甚至超越闭源系统。

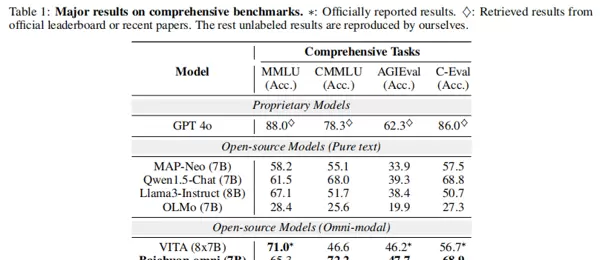

5.1 语言能力评估

评估基准

- 中文评测:CMMLU(覆盖 52 个学科领域的中文知识与推理)、C-Eval(13948 道选择题,涵盖广泛中文科目);

- 通用能力:MMLU(57 项任务,跨学科知识测试)、AGIEval(模拟人类资格考试,评估认知水平)。

实验结果

关键结论

- Baichuan-Omni 在中文基准上显著领先 VITA:CMMLU 达到 72.2%(VITA 为 46.6%),C-Eval 为 68.9%(VITA 为 56.7%),接近纯文本开源模型 Qwen1.5-Chat 的表现;

- 在 AGIEval 上也实现超越(47.7% vs 46.2%),表明全模态训练未损害语言能力,反而有所增益。

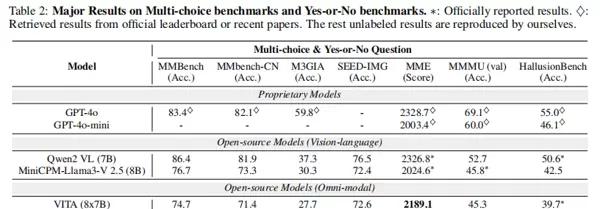

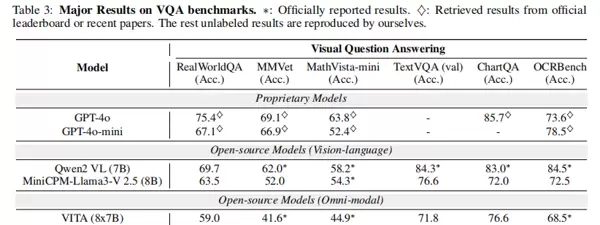

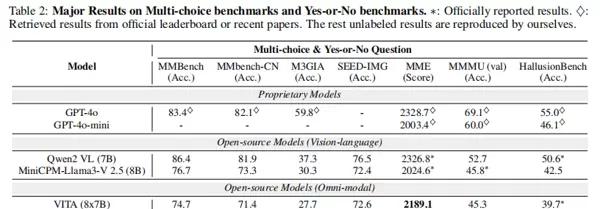

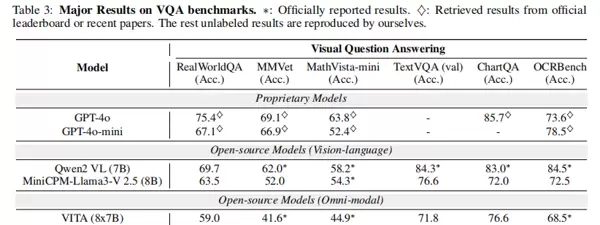

5.2 图像理解能力评估

评估基准

- 多选/判断类:MMBench-EN、MMBench-CN、M3GIA、SEED-IMG、MME、MMMU、HallusionBench;

- VQA 类任务:RealWorldQA、MMVet、MathVista-mini、TextVQA、ChartQA、OCRBench;

- 评估工具统一:所有实验均采用 VLMEvalKit 进行评测,确保结果可复现。

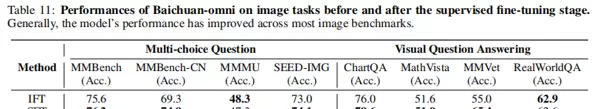

实验结果

关键结论

- 在 MMBench-CN、MMMU、MMVet 等核心指标上全面优于 VITA(如 MMVet 65.4% vs 41.6%);

- 与开源专用视觉语言模型相比,在抽象视觉任务(如 OCR、图表理解)上接近 MiniCPM-Llama3-V 2.5,某些任务(如 HallusionBench)甚至实现反超;

- 相较闭源模型,在高分辨率图像理解和复杂推理方面仍有差距,但在中文场景下具备更强表现力。

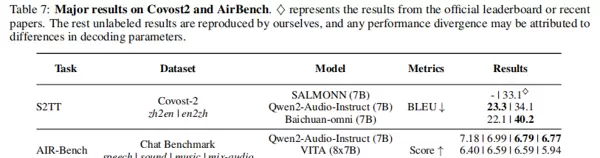

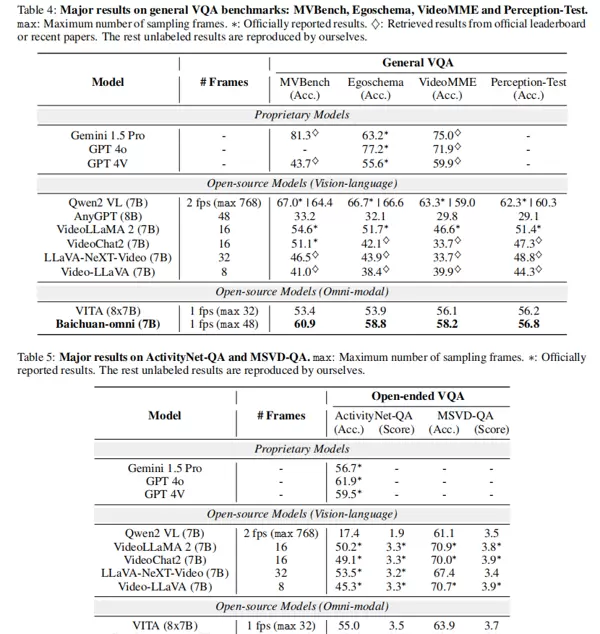

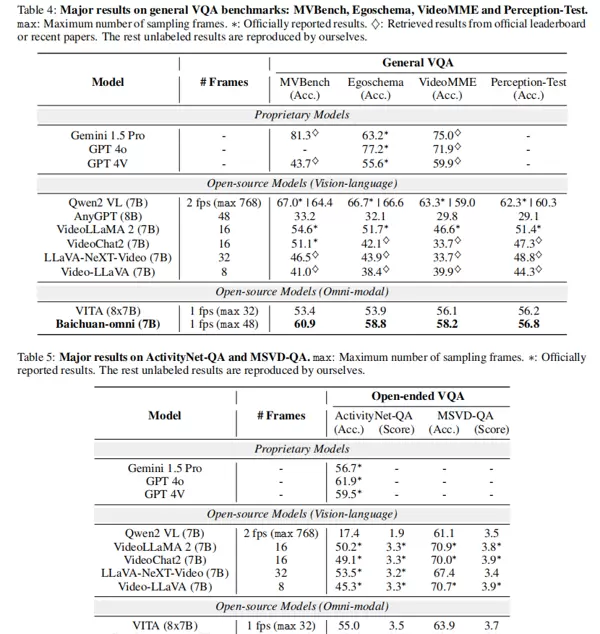

5.3 视频理解能力评估

评估基准

涵盖通用视频问答任务:MVBench、Egoschema、VideoMME(无字幕)、Perception-Test(以 top-1 准确率为评价标准)。

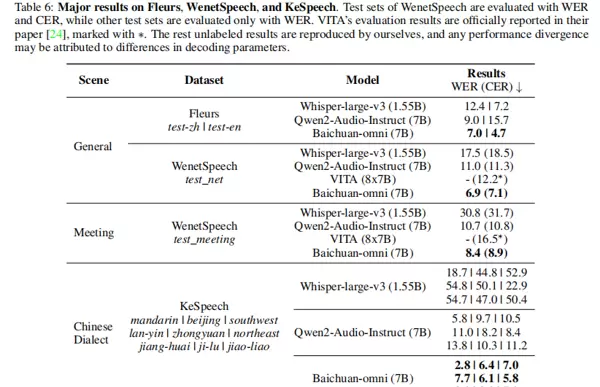

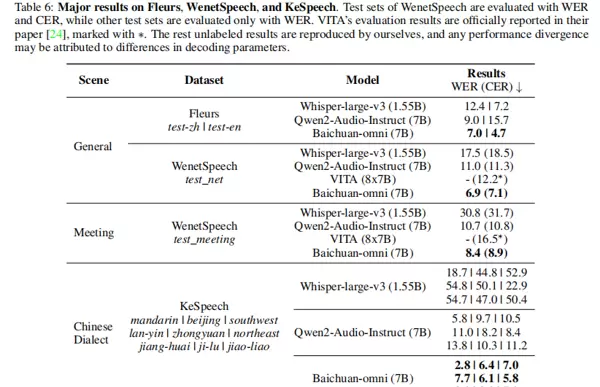

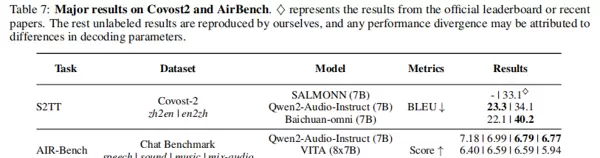

5.4 音频理解性能评估

评估任务:

- ASR(语音识别):涵盖通用场景(Fleurs-zh/en、WenetSpeech test_net)与复杂场景(WenetSpeech test_meeting、KeSpeech 方言),评价指标为 WER(词错误率)与 CER(字符错误率);

- S2TT(语音翻译):基于 Covost2 数据集进行中英互译(zh2en/en2zh),采用 BLEU 作为评估标准;

- 音频指令跟随:在 AIR-Bench 上测试模型对语音指令的理解能力,评分指标为 Score。

实验结果如下:

关键结论:

- ASR 表现突出:在中文语音识别任务中显著优于现有模型,Fleurs-zh 的 WER 低至 7.0%,优于 Qwen2-Audio-Instruct 的 9.0%;对方言的识别能力优异(KeSpeech 平均 CER 为 6.7%);在会议类复杂场景下(WenetSpeech test_meeting)CER 达到 8.9%,远超 VITA 的 16.5%;

- S2TT 翻译质量领先:en2zh 方向的 BLEU 分数达到 40.2,相比 Qwen2-Audio-Instruct 提升达 7 个点;

- 指令理解能力强:AIR-Bench 得分为 7.42,超过当前主流模型,体现其出色的音频交互能力。

开放式视频问答性能

评测数据集包括 ActivityNet-QA 和 MSVD-QA,使用 GPT-3.5-Turbo 对生成答案的正确性(Acc.)和整体质量(Score,范围 0–5)进行自动评估。

主要发现:

- 在开源模型中排名首位:ActivityNet-QA 准确率达到 58.6%,超越 Gemini 1.5 Pro(56.7%);

- MSVD-QA 上的答案质量更高,平均得分为 4.0,显示出更强的描述性语言生成能力;

- 通用视频 QA 任务中表现卓越,相较开源模型 VITA 平均提升 4%,在 MVBench(60.9% vs 53.4%)和 Egoschema(58.8% vs 53.9%)上均实现领先,并优于闭源模型 GPT-4V;

- 具备高效部署优势:仅使用 7B 参数量,帧采样数为 48 帧,远少于 Qwen2-VL 的 768 帧,但性能相当,显著降低计算成本。

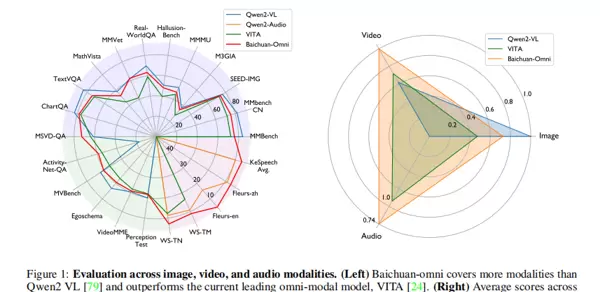

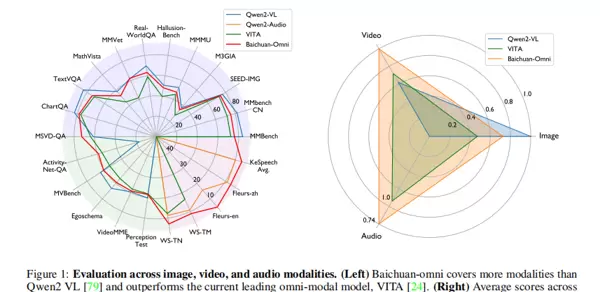

5.5 多模态综合性能分析

通过归一化公式 \(x_{norm}=(x-x_{min}+10)/(x_{max}-x_{min}+10)\),论文对各模型在图像、视频、音频三大模态上的综合表现进行了量化比较(见图 1)。

分析结果:

- 左图显示:Baichuan-Omni 支持文本、图像、视频、音频四类模态,而 Qwen2-VL 仅支持图文双模态;VITA 虽覆盖全模态,但整体性能较弱;

- 右图表明:Baichuan-Omni 的多模态平均得分达 0.74,明显高于 VITA,展现出更优的跨模态均衡性与全面领先性。

六、消融研究:关键技术模块有效性验证

为验证核心组件的设计价值,论文开展系统性消融实验,提供模型架构优化的实证依据。

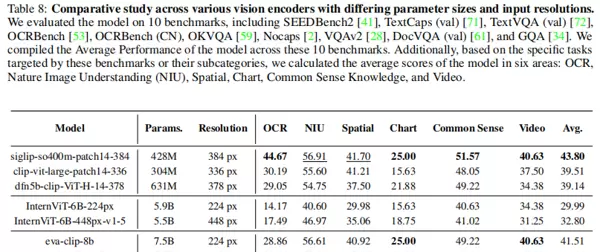

6.1 图像-语言分支关键组件分析

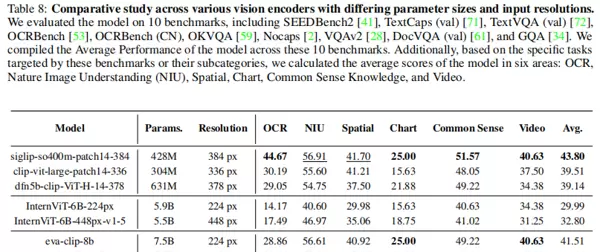

6.1.1 视觉编码器选型对比

对比 CLIP、Siglip、DFN、InternViT、EVA 五种视觉编码器的表现:

- 分辨率影响:相同模型结构下,高分辨率输入(如 eva-448 对比 eva-224)带来性能提升,但参数规模与性能无直接正相关关系;

- 最优方案:Siglip-so400m-patch14-384(428M 参数)在 OCR 与自然图像理解等 6 项子任务中 4 项表现最佳,平均分达 43.80,在性能与效率之间取得良好平衡。

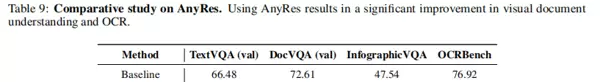

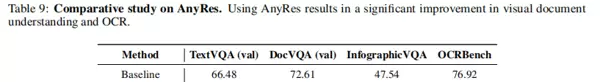

6.1.2 AnyRes 技术的作用

AnyRes 可支持任意分辨率输入并有效保留图像细节信息。

- 显著提升依赖细粒度视觉信息的任务表现,例如 DocVQA 指标提升高达 14.87 个百分点;

- 增强模型对多样化输入格式的适应能力。

6.1.3 视觉投影器类型比较

评估四种不同投影器在多项指标下的表现:

| 投影器类型 |

中文 OCR 理解能力 |

通用图像理解 |

参数效率 |

| MLP |

最优(0.75 轮拟合) |

良好 |

中等 |

| Mean Pool |

次优 |

良好 |

最优 |

| Concat |

较差 |

良好 |

较差 |

| C-abs |

最差(无法学习) |

良好 |

中等 |

最终选择 Mean Pool 投影器,因其在 OCR 能力、参数效率和通用性能之间实现了最佳折衷。

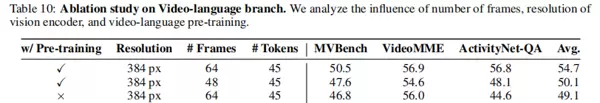

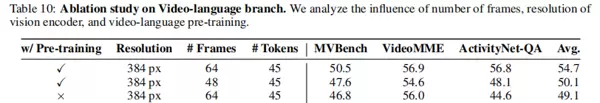

6.2 视频-语言分支关键因素探究

- 帧数影响:64 帧略优于 48 帧,但后者已能满足多数实际应用需求,兼顾推理效率;

- 分辨率策略:采用 AnyRes 动态处理优于固定 384px 分辨率,平均性能提升约 5%;

- 预训练必要性:视频模态的预训练至关重要,若缺失则在 MVBench 上性能下降达 6%。

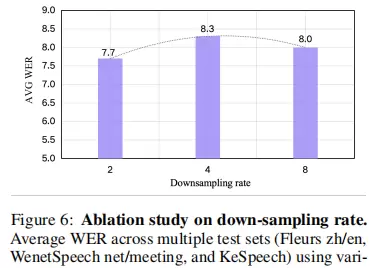

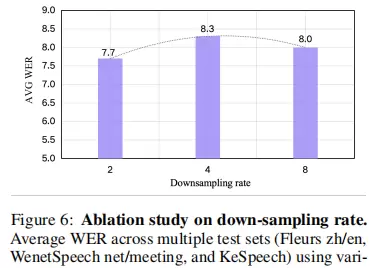

6.3 音频-语言分支:Conv-GMLP 下采样率的影响

测试不同下采样率(2、4、8)对 ASR 平均 WER 的影响(参见图 6):

- 下采样率为 2 时,WER 最低(7.7%),性能最优;

- 当下采样率提高至 4 或 8 时,WER 仅有轻微上升(分别为 8.3% 和 8.0%),仍显著优于传统池化方法;

- 关键发现:Conv-GMLP 即使在 8 倍高倍下采样条件下,仍能有效保留关键音频特征,表现出极强的信息保持鲁棒性。

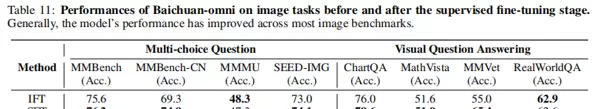

6.4 多模态 SFT 的影响分析

对比仅进行指令微调(IFT)与引入多模态监督微调(SFT)的性能差异:

- 加入多模态 SFT 后,模型在跨模态理解与生成任务中的表现显著提升;

- 证明了高质量、多样化的标注数据在提升模型泛化能力方面的关键作用。

图像任务(见表 11):经过监督微调(SFT)后,模型在 MMBench-CN 上的表现从 69.3 提升至 74.9,在 MMVet 上也由 55.0 显著上升至 65.4,显示出明显的性能增强;

视频任务(见表 12):SFT 后,ActivityNet-QA 准确率由 55.4 提高到 58.6,MSVD-QA 从 3.8 增长至 4.0。这些结果充分验证了高质量 SFT 数据对提升模型指令跟随能力的有效性。

七、结论与未来方向

7.1 核心总结

Baichuan-Omni 采用“高质量数据构建 → 分阶段模态对齐 → 多任务微调”的系统化框架,在仅 7B 参数规模下实现了全模态能力的突破:

- 模态覆盖广泛:支持文本、图像、视频和音频四类模态的并发处理;

- 综合性能领先:在开源模型中具备领先的多模态整体表现,尤其在中文理解与音频处理方面优势突出;

- 交互体验优化:创新性地引入流式处理架构,实现音视频内容的实时响应与交互;

- 开源贡献显著:公开完整的模型权重、训练代码及评估脚本,为社区提供可复现的全模态研究基线。

7.2 未来改进方向

论文明确提出了后续发展的四个重点方向:

- 强化文本提取能力:进一步提升对 OCR 输出、图表信息以及文档结构的理解精度;

- 拓展视频时长支持:突破现有 48 帧的时间限制,支持更长时间跨度的视频内容分析;

- 集成端到端 TTS 功能:构建“音频输入→文本理解→语音输出”的完整闭环交互流程;

- 增强环境音识别能力:扩展音频语义理解范围,涵盖如流水声、鸟鸣声、物体碰撞等自然环境声音的感知与解析。

八、技术启示与展望

Baichuan-Omni 的成功实践证实了“轻量化架构 + 高质量数据 + 精细化对齐”是构建高效全模态模型的有效路径,为开源生态提供了重要借鉴:

- 数据维度:多模态数据需兼顾多样性与高质量对齐,结合合成数据与公开资源可有效扩大任务覆盖范围;

- 架构设计:使用专用投影模块(例如 Conv-GMLP)和模态适配策略(如 AnyRes),能显著提升跨模态理解准确率;

- 交互机制:流式处理架构是推动全模态模型实际落地的关键,需在实时响应与计算效率之间取得良好平衡。

随着全模态技术持续演进,未来模型将逐步打破“模态壁垒”,实现更加自然流畅的人机交互体验,推动通用人工智能(AGI)向贴近人类感知方式的方向迈进。Baichuan-Omni 的全面开源,必将加速这一技术进程的发展步伐。

扫码加好友,拉您进群

扫码加好友,拉您进群

收藏

收藏