在当今技术浪潮中,人工智能正以前所未有的速度与深度渗透至各个行业。这一变革的背后,离不开一套日趋完善且高效的AI工具生态系统。从代码编写、数据处理到模型训练,每一个关键环节都已被智能化工具重新定义。本文将聚焦于三大支柱性工具——智能编码辅助系统、专业数据标注平台和高效模型训练环境,深入剖析它们如何协同驱动AI应用的发展,并通过代码片段、流程图、Prompt示例及图表展示其实际运作机制。

以GitHub Copilot为代表的智能编码工具,已从早期的“辅助补全”功能进化为开发者日常工作中不可或缺的“虚拟结对程序员”。这类工具依托大型语言模型(LLM),能够理解当前项目的上下文环境,实时提供高质量的代码建议,甚至自动生成完整函数逻辑。

基于OpenAI GPT系列模型构建,GitHub Copilot的核心优势在于其强大的上下文感知能力。它不仅能读取当前文件内容,还能分析项目中的其他相关代码以及注释信息,从而生成语义连贯、结构合理的代码建议。

主要价值体现:

以下是一个Python场景实例,展示Copilot如何将一段简单描述转化为完整的异步网络请求处理函数。

需求说明: 编写一个函数,接收一组URL地址,使用异步方式批量检测每个链接是否返回HTTP状态码200(即正常响应)。

开发者仅需输入如下注释:

# 编写一个异步函数,名为check_urls,它接收一个URL列表。

# 该函数应使用aiohttp库异步检查每个URL的HTTP状态码。

# 返回一个字典,键是URL,值是布尔值,表示URL是否可访问(状态码为200)。Copilot可能自动生成如下实现代码:

import aiohttp

import asyncio

from typing import List, Dict

async def check_urls(urls: List[str]) -> Dict[str, bool]:

"""

Asynchronously checks the status code of a list of URLs.

Args:

urls: A list of URL strings to check.

Returns:

A dictionary where keys are URLs and values are booleans

indicating if the URL is accessible (status code 200).

"""

results = {}

async with aiohttp.ClientSession() as session:

# 为每个URL创建一个任务

tasks = [check_single_url(session, url) for url in urls]

# 并发执行所有任务

accessible_statuses = await asyncio.gather(*tasks)

# 将结果组装成字典

for url, is_accessible in zip(urls, accessible_statuses):

results[url] = is_accessible

return results

async def check_single_url(session: aiohttp.ClientSession, url: str) -> bool:

"""Helper function to check a single URL."""

try:

async with session.get(url, timeout=10) as response:

return response.status == 200

except Exception:

return False

# --- 使用示例 ---

if __name__ == "__main__":

urls_to_check = [

"https://www.google.com" ,

"https://www.github.com" ,

"https://www.nonexistent-website-12345.com"

]

# 运行异步函数

results = asyncio.run(check_urls(urls_to_check))

print("URL Accessibility Check Results:")

for url, is_ok in results.items():

status = "OK" if is_ok else "Failed"

print(f"- {url}: {status}")该过程体现了Copilot的综合理解能力:准确识别“异步”、“aiohttp库调用”、“状态码判断”等关键词,并合理构建包含错误捕获、类型提示和调用示例的完整函数结构。

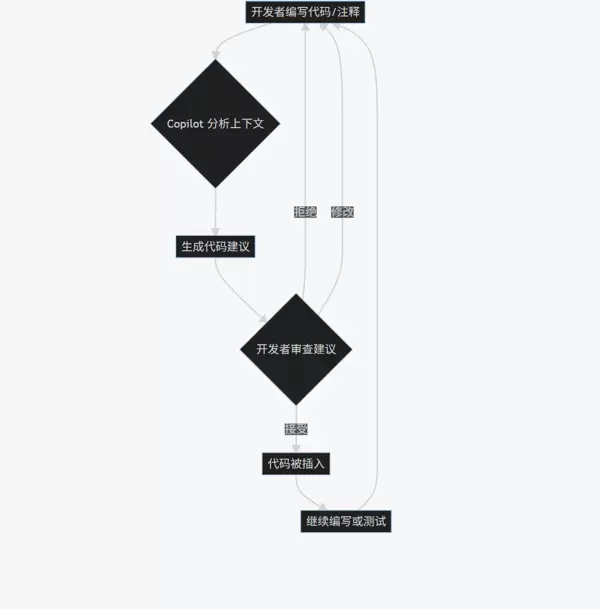

下图展示了开发者与Copilot交互的标准工作流:

在Copilot系统中,用户的代码与注释本身就是向AI发出的指令(Prompt)。高质量的Prompt能显著提升输出结果的准确性与实用性。

Prompt 示例 1(Web开发场景):

// 使用React和TypeScript创建一个名为UserProfile的组件。

// 该组件接收userId作为prop。

// 组件内部使用useState和useEffect钩子,

// 当userId改变时,从'/api/users/{userId}'获取用户数据并显示。

// 显示内容包括:name, email, 和一个头像。Prompt 示例 2(数据处理任务):

# 使用pandas读取'sales_data.csv'文件。

# 数据包含'product_id', 'sale_date', 'amount'三列。

# 请将'sale_date'转换为datetime对象,并设置为索引。

# 然后,按月计算总销售额,并生成一个条形图。优化建议:

如果说算法是人工智能的“大脑”,算力是“肌肉”,那么数据便是其赖以生存的“血液”。在监督学习体系中,模型的表现高度依赖于训练数据的质量。“垃圾进,垃圾出”这一原则始终成立。因此,构建高精度、结构化的标注数据集至关重要,而专业的数据标注工具正是为此而生。

使用通用编辑器进行手动标注不仅效率低下,而且难以保证一致性与可管理性。专业的数据标注平台提供了系统化的解决方案,涵盖:

| 数据模态 | 典型任务 | 工具核心功能 |

|---|---|---|

| 图像标注 | 图像分类、目标检测、语义/实例分割 | 绘制边界框、多边形、关键点、像素级掩码 |

| 文本标注 | 文本分类、命名实体识别(NER)、情感分析、关系抽取 | 文本高亮、标签选择、实体间关系连线 |

| 音频标注 | 语音识别(ASR)、声学事件检测、说话人日志 | 时间轴切片、语音转写、标签标注 |

| 视频标注 | 行为识别、目标跟踪 | 逐帧或关键帧标注、轨迹路径绘制 |

一个完整的数据标注流程通常包括以下几个阶段:

一个标准的数据标注项目通常包含一系列有序的步骤,其中专业化的工具在整个流程中起到关键作用。以下是典型的工作流:

flowchart LR

A[原始数据] --> B(导入标注平台);

B --> C{创建标注任务};

C --> D[分配给标注员];

D --> E[标注员进行标注];

E --> F{质检/审核};

F -- 通过 --> G[导出标注数据];

F -- 不通过 --> E;

G --> H[用于模型训练];

经过严格的质量控制后,最终输出的标注数据将被用于后续的模型训练阶段,确保输入数据的准确性和可用性。

在数据标注系统中,“Prompt”指的是提供给标注人员的具体操作指南,要求清晰且无歧义,以保证标注结果的一致性。

Prompt 示例1:图像目标检测

任务描述:

对城市道路场景中的各类车辆绘制精确的边界框。

可选标签类别:

carbustruck标注规范:

- 边界框应紧密贴合车辆轮廓,尽可能减少包含背景区域。

- 若车辆被部分遮挡但可见面积超过50%,仍需进行标注。

- 对于严重模糊或可见度低于50%的情况,则不予标注。

- 行人对象使用

pedestrianPrompt 示例2:文本命名实体识别

任务描述:

在指定新闻文本中识别并标注所有命名实体。

实体类型定义:

PERORGLOC标注规则说明:

- 实体需完整标注,例如“北京大学”应整体标注为

ORGLOCORG标注工具最终生成的是结构化数据文件,JSON 是最常用的格式之一。以下是一个基于 COCO 标准的目标检测 JSON 片段示例:

{

"images": [

{

"id": 1,

"file_name": "image_001.jpg",

"height": 720,

"width": 1280

}

],

"annotations": [

{

"id": 1,

"image_id": 1,

"category_id": 1, // 假设1代表"cat"

"bbox": [450, 300, 200, 150], // [x, y, width, height]

"area": 30000,

"iscrowd": 0

},

{

"id": 2,

"image_id": 1,

"category_id": 2, // 假设2代表"dog"

"bbox": [800, 320, 180, 160],

"area": 28800,

"iscrowd": 0

}

],

"categories": [

{"id": 1, "name": "cat"},

{"id": 2, "name": "dog"}

]

}此类结构化的标注结果可直接被主流深度学习框架(如 PyTorch、TensorFlow)读取和处理,进而投入到模型训练流程中。

bar-chart

title 不同数据标注任务的相对复杂度与成本

x-axis 标注类型

y-axis "相对成本/时间"

series 成本

"图像分类": 1

"目标检测": 3

"语义分割": 8

"文本分类": 2

"命名实体识别": 4

该图表表明,随着标注粒度的提升——从简单的分类到像素级的语义分割——所需的人力投入和时间成本呈显著上升趋势,反映出高精度标注任务更高的资源消耗特性。

在完成数据准备与代码实现之后,模型训练进入资源消耗最大、技术复杂度最高的阶段。为此,模型训练平台(也称 MLOps 平台)应运而生,旨在为机器学习工程师提供覆盖实验、训练到部署全生命周期的一体化管理环境。

在本地设备上执行模型训练,尤其面对大规模数据集和深层网络结构时,常面临以下问题:

模型训练平台通过标准化流程与自动化机制,有效缓解上述痛点。

| 组件 | 功能 | 常见工具/服务 |

|---|---|---|

| 计算资源管理 | 动态调度 CPU/GPU/TPU 集群,支持分布式训练 | Kubernetes, NVIDIA DGX, AWS SageMaker, Google Vertex AI |

| 实验跟踪 | 记录每次运行的代码、配置、超参数及评估指标 | Weights & Biases (W&B), MLflow, TensorBoard |

| 模型注册表 | 集中存储训练好的模型及其元信息,支持版本控制 | MLflow Model Registry, SageMaker Model Registry |

| 自动化流水线 | 整合数据预处理、训练、评估、部署等环节,形成可复现流程 | Kubeflow Pipelines, TensorFlow Extended (TFX), Azure ML Pipelines |

| 特征存储 | 统一管理特征数据,保障训练与推理阶段的一致性 | Feast, Tecton |

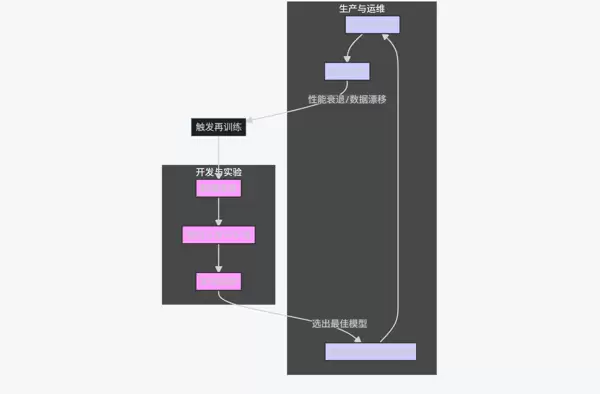

模型训练平台是实现 MLOps 理念的关键支撑。下图展示了其驱动下的完整生命周期:

flowchart TD

subgraph "开发与实验"

A[数据准备] --> B[模型开发与实验];

B --> C[实验跟踪];

end

subgraph "生产与运维"

D[模型注册与版本控制] --> E[自动化部署];

E --> F[线上监控];

end

C -- 选出最佳模型 --> D;

F -- 性能衰退/数据漂移 --> G[触发再训练];

G --> A;

Prompt示例1(超参数搜索配置 — 使用W&B Sweep):

# sweep_config.yaml

program: train.py

method: bayes # 使用贝叶斯优化进行搜索

metric:

name: val_accuracy

goal: maximize

parameters:

learning_rate:

min: 0.0001

max: 0.1

distribution: log_uniform_values

batch_size:

values: [32, 64, 128]

dropout:

min: 0.1

max: 0.5

distribution: uniformtrain.pyval_accuracyPrompt示例2(构建机器学习流水线 — 基于Kubeflow Pipelines):

# 这是一个简化的Python DSL示例

from kfp import dsl

@dsl.component

def preprocess_op(data_path: str):

# ... 数据预处理逻辑 ...

return processed_data_path

@dsl.component

def train_op(processed_data_path: str, learning_rate: float):

# ... 模型训练逻辑 ...

return model_path

@dsl.pipeline

def my_ml_pipeline(data_path: str, learning_rate: float = 0.01):

preprocess_task = preprocess_op(data_path=data_path)

train_task = train_op(

processed_data_path=preprocess_task.output,

learning_rate=learning_rate

)preprocesstrain

import wandb

import torch

import torch.nn as nn

import torch.optim as optim

from torchvision import datasets, transforms

from torch.utils.data import DataLoader

# 1. 初始化W&B项目

wandb.init(

project="my-mnist-project",

config={

"learning_rate": 0.01,

"batch_size": 64,

"architecture": "CNN",

"epochs": 10,

}

)

# 从wandb.config中获取超参数,便于在UI中调整

config = wandb.config

# 简单的CNN模型

class SimpleCNN(nn.Module):

def __init__(self):

super(SimpleCNN, self).__init__()

self.conv1 = nn.Conv2d(1, 32, 3, 1)

self.conv2 = nn.Conv2d(32, 64, 3, 1)

self.dropout1 = nn.Dropout(0.25)

self.dropout2 = nn.Dropout(0.5)

self.fc1 = nn.Linear(9216, 128)

self.fc2 = nn.Linear(128, 10)

def forward(self, x):

x = self.conv1(x)

x = torch.relu(x)

x = self.conv2(x)

x = torch.relu(x)

x = torch.max_pool2d(x, 2)

x = self.dropout1(x)

x = torch.flatten(x, 1)

x = self.fc1(x)

x = torch.relu(x)

x = self.dropout2(x)

x = self.fc2(x)

output = torch.log_softmax(x, dim=1)

return output

# 数据准备和模型实例化

transform = transforms.Compose([transforms.ToTensor()])

train_dataset = datasets.MNIST('./data', train=True, download=True, transform=transform)

train_loader = DataLoader(train_dataset, batch_size=config.batch_size, shuffle=True)

model = SimpleCNN()

optimizer = optim.Adam(model.parameters(), lr=config.learning_rate)

criterion = nn.NLLLoss()

# 训练循环

model.train()

for epoch in range(config.epochs):

for batch_idx, (data, target) in enumerate(train_loader):

optimizer.zero_grad()

output = model(data)

loss = criterion(output, target)

loss.backward()

optimizer.step()

# 2. 记录指标到W&B

if batch_idx % 100 == 0:

wandb.log({

"epoch": epoch,

"batch_loss": loss.item(),

# 可以记录更多自定义指标

})

print(f"Epoch {epoch}, Batch {batch_idx}, Loss: {loss.item()}")

# 3. (可选) 保存模型到W&B

wandb.save("my_model.pth")

wandb.finish()batch_lossepoch[图片:模型训练平台(如W&B或TensorBoard)的实验跟踪仪表盘截图]

扫码加好友,拉您进群

扫码加好友,拉您进群

收藏

收藏