可解释机器学习正从简单的事后热力图可视化,逐步演进为具备可干预、可验证与可对话能力的结构化解释体系。从 ProtoPNet 到 Concept Bottleneck,再到对大语言模型机制的系统性解析与统一评测基准的建立,该领域正在经历深刻变革。本期聚焦 NeurIPS、ICML、CVPR 等顶级会议与期刊中的 20 篇代表性论文,涵盖概念瓶颈、原型网络、梯度归因、因果消融以及大语言模型可解释性等核心方向,帮助读者快速掌握当前研究的关键脉络与前沿进展。

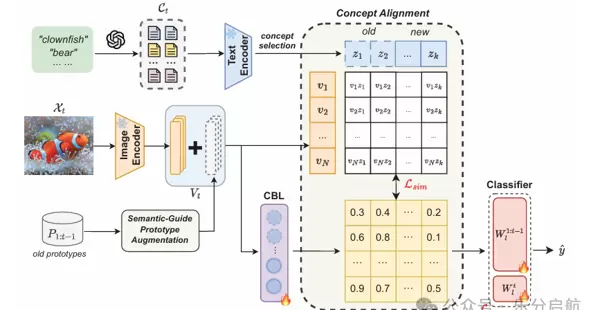

Language Guided Concept Bottleneck Models for Interpretable Continual Learning

核心思想: 提出一种融合语言引导的概念瓶颈模型,有效应对连续学习过程中知识遗忘与模型透明度不足的双重难题。

技术路径: 引入概念瓶颈层,并通过与 CLIP 模型对齐语义空间,使模型能够学习到跨任务通用且人类可理解的高层语义概念,从而增强泛化能力与解释性。

实验结果: 在包括 ImageNet-subset 在内的多个基准数据集上进行了验证,最终平均准确率相较现有最优方法提升了 3.06%。同时提供了直观的预测概念可视化结果,进一步揭示了模型在持续学习中的决策逻辑演化过程。

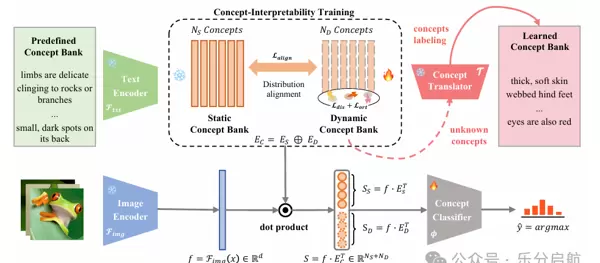

Hybrid Concept Bottleneck Models

核心思想: 针对传统概念瓶颈模型依赖预定义概念集合而导致覆盖不全的问题,提出 HybridCBM 框架,结合静态与动态概念库以提升解释完整性与模型性能。

技术路径: 构建双轨制概念存储机制:静态概念库由大型语言模型生成初始语义概念;动态概念库则通过可训练向量在训练过程中不断捕捉未被覆盖的重要隐含概念。

实验结果: 在多个公开数据集上的测试表明,HybridCBM 不仅优于现有的先进 CBM 方法,其分类性能也接近黑盒模型水平。研究还设计了新的评估指标用于衡量所学概念的质量,结果显示其与人工预定义概念具有相当的表现力。

Interpretable Generative Models through Post-hoc Concept Bottlenecks

核心思想: 探索低成本构建可解释生成模型的新范式,提出两种基于后处理概念瓶颈的技术(CB-AE 和 CC),显著提升生成过程的可控性与解释能力。

技术路径: 将概念瓶颈机制引入自动编码器(CB-AE)和控制器(CC)架构中,实现无需真实标签监督、仅需极少概念标注即可完成训练的目标。

实验结果: 在 CelebA、CelebA-HQ 与 CUB 等标准图像数据集上进行验证,方法在解释性和控制精度方面平均提升约 25%。此外,大规模用户研究表明,该方法在实际交互场景中具备良好的可用性与感知可信度。

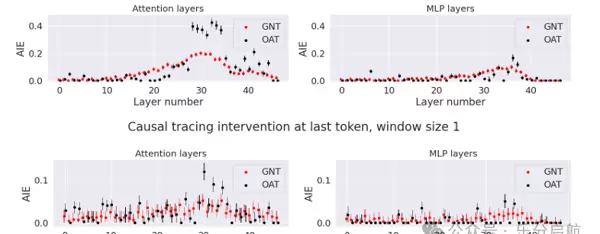

Optimal Ablation for Interpretability

核心思想: 提出“最优消融”(Optimal Ablation, OA)作为新型解释工具,用于量化神经网络内部组件的重要性,推动模型解释从相关性分析走向因果推断。

技术路径: 通过系统性禁用模型特定模块并测量其对任务性能的影响,OA 方法旨在识别出对输出影响最大的关键组件,提供更具因果意义的解释依据。

实验结果: 在电路发现、事实回溯定位及潜在变量预测等多个典型解释任务中验证了 OA 的有效性。尽管具体数据集未在摘要中详述,但实验证明该方法在识别关键功能单元方面优于现有基线,展现出强大的解释潜力。

扫码加好友,拉您进群

扫码加好友,拉您进群