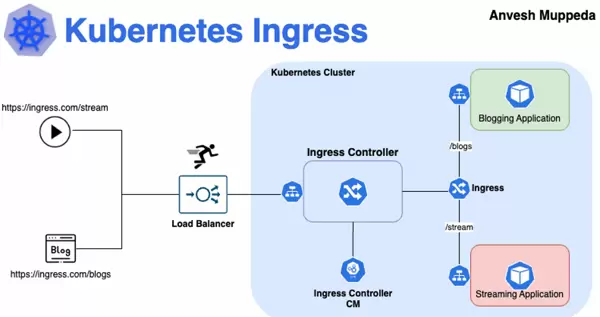

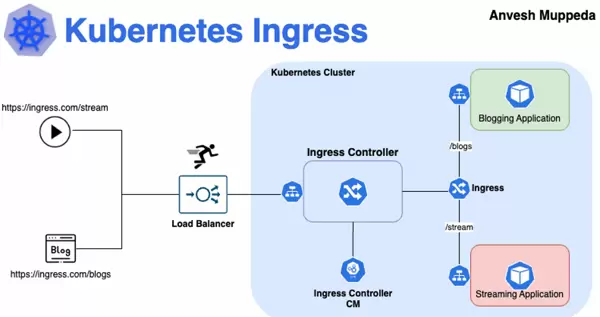

在现代云原生架构中,一个高效的流量调度系统对于微服务通信至关重要。Kubernetes 集群中的数百个微服务需要通过统一的入口进行管理,而 Ingress 正是实现这一目标的核心组件。当你使用域名访问部署在 Kubernetes 上的应用时,背后其实是由 Ingress 主导的一场精细的流量分发过程。

要理解 Ingress 的价值,首先需回顾 Kubernetes 中传统的服务暴露方式。Service 资源主要工作在传输层(第四层),依赖 TCP/IP 协议和端口号完成流量转发。这种机制虽然直接有效,但在面对大规模微服务场景时显得力不从心——每个对外暴露的服务通常都需要独立的负载均衡器与公网 IP,导致资源浪费和运维复杂度急剧上升。

Ingress 应运而生,作为 Kubernetes 的一种 API 对象,它运行于应用层(第七层),能够解析 HTTP/HTTPS 请求中的主机名、路径等语义信息。借助 Ingress,多个后端服务可以通过同一个入口点对外提供服务,并依据请求的域名或 URL 路径实现精准路由。

举例来说,若集群内有 10 个微服务,采用 LoadBalancer 类型的 Service 将可能产生 10 个云平台负载均衡实例;而引入 Ingress 后,仅需一个统一的入口控制器配合灵活的路由规则即可完成相同任务。这不仅显著降低了成本,也极大简化了外部访问的配置与维护流程。

Ingress 的核心设计理念在于将“规则定义”与“规则执行”解耦,即 Ingress 资源 和 Ingress 控制器 的分离结构。

Ingress 资源是用户编写的、用于描述路由逻辑的 YAML 配置,遵循 Kubernetes 声明式 API 规范。以下是一个典型的 Ingress 定义示例:

apiVersion: networking.k8s.io/v1

kind: Ingress

metadata:

name: example-ingress

spec:

ingressClassName: nginx

rules:

- host: "app.example.com"

http:

paths:

- path: "/api"

pathType: Prefix

backend:

service:

name: api-service

port:

number: 80

- path: "/web"

pathType: Prefix

backend:

service:

name: web-service

port:

number: 80

该配置表示:所有发往 app.example.com 的请求,若路径以 /api 开头,则被代理至名为 api-service 的后端服务;若路径以 /web 开头,则交由 web-service 处理。

app.example.com/apiapi-service/webweb-serviceIngress 资源本身不具备执行能力,仅是对期望状态的描述。真正负责实施路由功能的是 Ingress 控制器——一个持续运行的 Pod 实例。

控制器通过监听 Kubernetes API Server 中 Ingress、Service 及 Endpoint 资源的变化,实时感知集群状态更新。一旦检测到新的规则变更,便会将其转化为底层反向代理(如 Nginx、HAProxy 或云厂商 LB)可识别的配置文件。

以 Nginx Ingress 控制器为例,其典型工作流程包括:

这种“声明 + 控制”的分离模式体现了 Kubernetes 的典型设计哲学:用户只需关注“想要什么”,控制器自动处理“如何实现”。

Ingress 支持两种主流的路由方式:基于主机名 和 基于路径,二者可单独使用也可组合配置。

主机名路由允许将不同域名指向不同的后端服务,例如:

spec:

rules:

- host: "api.example.com"

http:

paths:

- path: "/"

backend:

service:

name: api-service

port: 80

- host: "web.example.com"

http:

paths:

- path: "/"

backend:

service:

name: web-service

port: 80

而在同一域名下,可通过路径前缀区分服务版本或模块,实现细粒度分流:

spec:

rules:

- host: "example.com"

http:

paths:

- path: "/v1/users"

backend: ... # 用户服务 v1 版本

- path: "/v2/users"

backend: ... # 用户服务 v2 版本

通过上述机制,Ingress 实现了灵活、高效且集中化的七层流量管理能力,成为现代 Kubernetes 环境不可或缺的关键组件。

路径匹配类型详解

Ingress中的路径匹配支持三种主要模式,理解其差异对于正确配置路由规则至关重要。

| 路径类型 | 说明 | 示例匹配 |

|---|---|---|

| 精确匹配(Exact) | 区分大小写,仅当请求路径与定义完全一致时才匹配 | |

| 前缀匹配(Prefix) | 按路径元素逐级比较,只要前缀相同即可匹配 | |

| 实现依赖匹配(ImplementationSpecific) | 具体行为由Ingress控制器决定 | |

当多个路径规则存在冲突时,系统遵循“最长路径优先”的原则进行选择;若路径长度相同,则精确匹配的优先级高于前缀匹配。

/apiIngress原生具备处理HTTPS流量的能力,可在入口层完成SSL/TLS连接的终止,并将解密后的HTTP请求转发至后端服务。示例如下:

spec:

tls:

- hosts:

- "app.example.com"

secretName: tls-secret # 引用包含证书和私钥的Kubernetes Secret

rules:

- host: "app.example.com"

http:

paths: ...

该机制将加密解密操作从应用层卸载到Ingress层面,不仅简化了服务逻辑,还实现了证书的集中管理与统一更新。

尽管Ingress资源本身不直接定义负载均衡算法,但可通过控制器特定的注解(Annotation)来启用多种策略。以Nginx Ingress为例,支持以下常见方式:

此外,大多数Ingress控制器内置健康检查功能,能够自动探测后端状态并将其从可用池中剔除,从而保障流量仅被路由至正常运行的服务节点。

现代Ingress控制器已超越基础路由功能,提供一系列增强型特性:

Kubernetes生态中存在多种Ingress控制器实现,各自适用于不同场景:

| 控制器 | 特点 | 适用场景 |

|---|---|---|

| Nginx Ingress | 由Kubernetes官方维护,功能全面,社区支持强大 | 通用部署环境,尤其适合需要深度定制Nginx配置的场景 |

| Traefik | 天然支持多类服务发现机制,配置动态更新迅速 | 微服务架构下频繁变更服务的场景 |

| HAProxy Ingress | 性能卓越,内存占用低 | 高并发、高吞吐量或资源受限的运行环境 |

| 云厂商原生方案 (如AWS ALB、GCE Ingress) |

深度集成对应云平台,通常为托管服务 | 在特定公有云上运行且希望降低运维复杂度的企业 |

以阿里云为例,提供了三种Ingress解决方案以满足多样化需求:

在选型过程中,应综合评估团队技术栈、性能预期、云平台兼容性及特定功能要求。

随着企业IT架构向混合云与多云演进,Ingress作为统一入口的价值愈发突出。

Traefik Labs 提出的“应用智能层”理念具有代表性——通过一个统一的入口层整合不同计算平台,包括传统虚拟机(EC2)、容器服务(ECS)以及Kubernetes集群(EKS),实现跨平台的一致性接入。

此类架构的主要优势包括:

红帽OpenShift结合Nginx Ingress的实际案例印证了这一模式的有效性。借助 NGINX Ingress Operator,企业可在跨地域、跨云服务商(如本地数据中心、AWS、Azure等)的OpenShift集群中,实现Ingress控制器的自动化部署与统一管理。

在生产环境中部署Ingress时,必须高度重视安全性,推荐采取以下措施:

由于Ingress承载所有外部入站流量,其自身的高可用性至关重要:

要保障 Ingress 的稳定运行,建立完善的监控体系是关键基础。通过多维度的可观测性手段,可以快速发现并定位问题,提升系统的可维护性。

配置 Ingress 控制器输出结构化的日志格式(如 JSON),有助于后续的日志采集、解析和分析。结构化日志能够支持更高效的告警触发和故障排查,尤其在大规模集群环境中尤为重要。

利用控制器自带的指标端点,持续采集核心性能数据,包括请求总量、响应延迟、错误率等关键指标。这些数据可通过 Prometheus 等监控系统进行抓取,用于绘制仪表盘或驱动自动化策略。

在 Ingress 层注入统一的追踪标识符(如 trace ID),实现请求从入口网关到后端微服务的全链路追踪。这有助于理解流量路径、识别瓶颈环节,并加速跨服务问题的诊断过程。

针对异常行为设置精细化的告警机制,例如错误率突然上升、平均延迟显著增加或连接超时频繁发生等情况。及时的通知机制可以帮助团队在用户感知前发现问题并快速响应。

虽然 Ingress 当前仍在 Kubernetes 生态中广泛使用,但官方已明确表示:

“Ingress 已停止功能更新,所有新特性将集中于 Gateway API。”

这意味着 Gateway API 正式成为下一代 Kubernetes 网络标准,旨在克服传统 Ingress 模型中存在的多个根本性局限。

Gateway API 支持基于 HTTP 请求头、查询参数、方法类型等条件进行细粒度路由匹配,满足复杂业务场景下的精确流量控制需求。

允许路由规则跨越命名空间边界,实现从单一入口访问多个命名空间中的服务,提升了资源组织的灵活性和复用性。

通过不同的自定义资源分别面向基础设施提供者、集群管理员和应用开发者,实现了权限与配置的解耦,增强了安全性和管理效率。

采用策略附加机制和可扩展的自定义资源模型,使得第三方实现可以轻松集成特定功能,如认证插件、限流策略或 WAF 集成。

对于已有系统而言,Ingress 依然是成熟且可靠的选择;但对于新建项目,尤其是对流量治理有更高要求的应用架构,建议密切关注 Gateway API 的发展并逐步引入实践。

Kubernetes Ingress 作为集群外部流量的智能调度中枢,凭借其声明式的 API 设计与灵活的控制器生态,将复杂的七层负载均衡逻辑抽象为标准化的资源对象。无论是基础的域名与路径路由,还是高级的灰度发布、安全控制及监控集成,Ingress 都已成为现代云原生架构中不可或缺的核心组件。

随着企业数字化进程加快以及混合云部署模式的普及,Ingress 及其演进形态 Gateway API 将持续承担起连接内外部服务、保障通信安全与优化访问性能的关键角色。深入掌握 Ingress 的原理与最佳实践,不仅是 Kubernetes 运维人员的技术必备项,更是构建高效、可靠、安全的云原生体系的重要支撑。

确保 Ingress 控制器至少运行两个副本,并分布在不同的工作节点上,以避免单点故障影响整个集群的对外服务能力。

通过设置 Pod 反亲和性规则,强制控制器的不同副本被调度至独立节点,防止因节点宕机导致入口服务完全中断。

合理配置存活探针(liveness probe)和就绪探针(readiness probe),使不健康的实例能被及时发现并替换,保障流量始终只转发至正常运行的副本。

定期监控控制器的 CPU 和内存使用情况,结合历史流量趋势进行容量评估。在预期流量高峰前主动扩容,确保系统具备足够的处理能力。

扫码加好友,拉您进群

扫码加好友,拉您进群

收藏

收藏