一、研究背景与挑战

在数字内容创作领域,实现对视频拍摄视角和光照效果的自由调控,是一项极具潜力的技术突破,可广泛应用于电影制作、虚拟现实及增强现实等场景。然而,现有方法通常只能独立调节相机视角或光照条件,难以实现两者的协同控制。更为关键的是,要训练一个能够同时理解多视角与多光照变化的模型,需要大量包含这两种变化的视频数据,而现实中几乎不存在此类高质量、多角度、多光照的同步视频数据集,这成为制约该方向发展的主要瓶颈。

二、Light-X框架概述

针对上述难题,本文提出了一种名为Light-X的新型生成式4D视频渲染框架,其核心在于实现了相机运动与光照条件的解耦联合控制。该方法通过分别建模几何结构与光照信息,并在后续阶段进行融合,从而有效解决了复杂动态场景下的视角变换与光照编辑问题。实验验证表明,Light-X不仅能在新视角下保持真实感光照效果,还在时间序列上的连续性方面表现优异,显著优于当前主流方法。

三、主要贡献

- 首次实现相机轨迹与光照效果的联合控制:提出Light-X框架,支持对单目输入视频进行任意视角切换与可控光照重置。

- 构建Light-Syn数据生成管线:通过逆向映射技术,从普通单视角视频中合成具有多视角与多光照特性的虚拟训练样本,缓解真实数据稀缺问题。

- 设计解耦的条件注入机制:将几何/运动线索与光照信息分离处理,确保扩散模型能精准响应各自控制信号。

- 性能达到业界领先水平:在联合控制任务以及纯重打光任务中,均展现出卓越的视觉质量与稳定性。

四、方法原理与架构解析

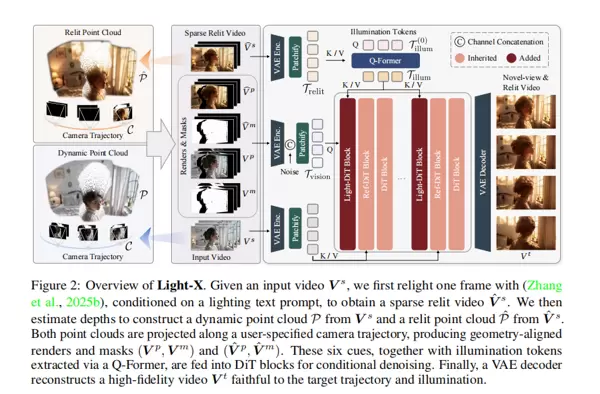

Light-X的核心思想是将复杂的视频生成问题分解为两个独立但互补的子任务——几何建模与光照建模。具体而言,模型通过构建两组动态点云来分别编码场景的空间结构与光照响应特性,从而实现精细化的控制能力。

图2:Light-X整体架构示意图

1. 相机与光照的解耦建模

为了避免相机参数与光照条件之间的干扰,Light-X采用了解耦式的建模范式,为扩散模型提供清晰且无歧义的引导输入。

(1)相机控制流程

为实现精确的视角变换,模型首先利用现有的深度估计算法,为输入视频 $V_s$ 的每一帧图像 $I_i^s$ 提取对应的深度图 $D_i^s$。结合已知的相机内参 $K$ 和逆透视投影函数 $\Phi^{-1}$,将每个像素及其深度“提升”至三维空间,形成随时间演化的动态点云 $P$:

$$

P_i = \Phi^{-1}(I_s^i, D_s^i; K)

$$

该点云 $P_i$ 包含了第 $i$ 帧的几何形状与表面颜色信息。当用户指定新的相机轨迹 $C = \{[R_i, t_i]\}$ 时,系统通过对点云应用新的旋转矩阵 $R_i$ 和平移向量 $t_i$,再经由透视投影函数 $\Phi$ 将其重新投影回二维平面,生成几何对齐的渲染视图 $V_p$ 与可见性掩码 $V_m$:

$$

I_p^i, M_p^i = \Phi(R_i P_i + t_i; K)

$$

由此得到的 $V_p$ 与 $V_m$ 共同构成新视角下的几何先验,明确指示场景结构及遮挡关系,为后续光照合成提供可靠基础。

(2)光照控制机制

为了引入可控的光照变化,模型借助先进的单图重打光工具 IC-Light,仅对输入视频中的某一关键帧(如首帧)根据文本提示(例如“霓虹灯风格”)进行光照重定向,生成一张重打光后的图像。随后,构建一个稀疏的重打光视频 $\hat{V}_s$,其中仅该帧被替换为新光照图像,其余帧为空白。

接着,利用原始视频所提取的同一套深度图 $D_s$,将此稀疏视频同样通过 $\Phi^{-1}$ 映射到三维空间,生成一组特殊的“重打光点云” $\hat{P}$:

$$

\hat{P}_i = \Phi^{-1}(\hat{I}_s^i, D_s^i; K)

$$

这一设计使得光照变化的信息被编码进三维点云中,便于后续与几何信息进行对齐与融合,从而实现跨视角的一致性光照传播。

五、总结

本研究提出的Light-X框架,成功实现了对单目视频在任意视角和光照条件下的联合编辑。通过创新的数据合成策略、解耦的建模方式以及高效的条件注入机制,克服了真实数据缺失与控制耦合两大挑战。实验证明,该方法在生成质量、时间连贯性和控制灵活性方面均处于领先水平,为未来高自由度视频编辑提供了可行路径。

通过解耦策略,模型分别获得了几何运动信息(Vp, Vm)与光照变化信号(Vp, Vm)。这些多模态信号被统一整合进一个基于 Transformer 架构的视频扩散模型(DiT)中,用于驱动高质量视频的生成过程。

细粒度线索注入机制

首先,利用预训练的变分自编码器(VAE),将四类输入信号——原始点云投影视图 Vp、对应掩码 Vm、重打光点云视图 Vp 和其掩码 Vm ——映射至潜在扩散空间。随后,这些特征在通道维度上与随机噪声进行拼接,并被切分为一系列视觉令牌(tokens)。每个令牌均融合了场景内容、几何动态以及光照调整的信息,为后续扩散过程中的去噪操作提供精细指导。

全局光照一致性维持

实验发现,仅依赖局部细粒度信号时,生成视频中的光照效果会随时间推移逐渐衰减。为此,研究引入了一个全局光照控制模块。该模块借助 Q-Former 结构,从单张已知的重打光帧中提取出整体光照特征,形成“光照令牌” Tillum。这些令牌通过交叉注意力机制嵌入到模型每一层的处理流程中:

T′vision = CrossAttn(Q = Tvision, K = V = Tillum)

这一设计相当于在整个生成过程中持续提醒网络:“保持当前的全局光照风格”,从而有效增强了光照表现的时间稳定性与一致性。

Light-DiT

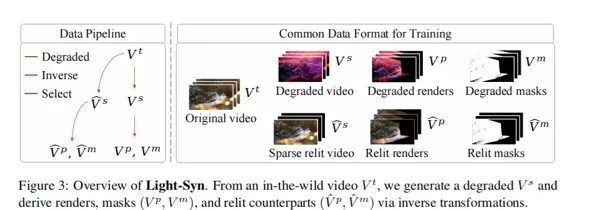

Light-Syn:数据合成管线设计

针对训练数据稀缺的问题,作者提出了一种创新性的数据构建方案——Light-Syn,其核心思想是“以果为因,逆向构造”训练样本。

如图所示,该方法不依赖难以获取的真实成对数据,而是直接从互联网采集高质量普通视频作为目标真值 Vt。接着,通过对该视频施加可控的降质操作(如使用低质量模型进行视角变换或光照修改),生成对应的退化输入 Vs。由于从 Vt 到 Vs 的变换路径完全已知,模型可反向计算出精确的几何与光照条件信号(如 Vp, Vp 等)。借助此策略,研究团队从静态场景、动态实景及AI生成视频三类来源大规模合成了训练数据,显著缓解了数据瓶颈问题。

实验设置与评估体系

为全面验证 Light-X 在联合控制与视频重打光任务上的性能,实验采用了来自 Pexels、Sora 等平台的 200 个高清晰度视频构成测试集,涵盖人物、动物和各类物体运动场景。评估指标体系覆盖多个维度:包括图像质量(FID、美学评分)、时间连贯性(CLIP 相似度、运动保持度)以及多角度人工主观评价。

对比实验结果分析

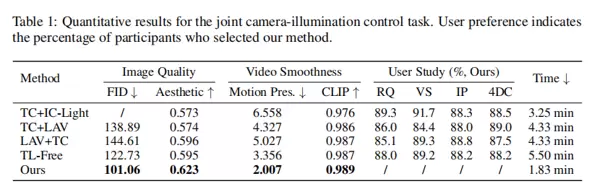

联合相机-光照控制任务

由于缺乏直接竞品,研究人员将现有相机轨迹控制方法 TrajectoryCrafter 与主流重打光技术(IC-Light、LAV)组合,构建基线模型进行对比。

量化结果显示(见表1),Light-X 在所有关键指标上均取得领先:FID 分数最低(101.06),表明图像保真度最优;美学得分为 0.623,位居榜首;在用户偏好测试中也获得压倒性支持。

定性比较进一步证实了其优势。如图5所示,在大角度视角切换下,基线方法常出现光照畸变或帧间闪烁现象,而 Light-X 仍能稳定输出视角准确、光照自然且时序平滑的视频序列。

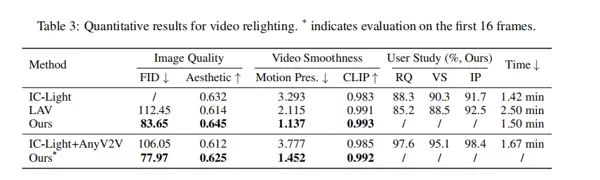

视频重打光专项任务

在独立的视频重打光任务中,Light-X 与 IC-Light(逐帧处理)和 LAV 等先进方法展开对比。

根据表3 数据,Light-X 在 FID(83.65)和美学得分(0.645)两项核心指标上均达到最优水平,展现出更强的光照迁移能力与视觉自然性。

同样地,经过重打光处理的点云数据也被投影至新的相机轨迹下,生成相应的重打光影像 Vp 及其掩码 Vm。这两个信号提供了细粒度的光照引导信息,精准指示在新光照条件下场景各区域应有的颜色变化方式。

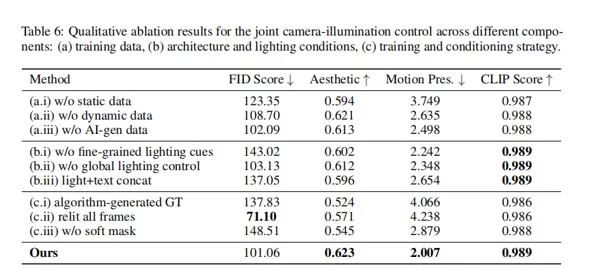

消融实验

为了验证模型中各个组件的有效性与必要性,研究进行了系统的消融实验。实验结果如表6所示,清晰地展示了不同模块和训练策略对整体性能的影响。

(a) 当移除静态、动态或AI生成的任意一类训练数据时,模型的整体表现均出现下降,表明Light-Syn数据策略中多种数据来源之间存在显著的互补作用,缺一不可。

(b.i) 若去除细粒度光照线索(即 \(\hat{V}_p\)),FID分数急剧上升至143.02,说明重打光效果严重退化,进一步证明该线索在保持光照细节方面的关键地位。

(b.ii) 移除全局光照控制模块后,尽管FID变化不明显,但通过视觉观察可发现光照效果随时间推移逐渐衰减,这反映出该模块在维持视频时间一致性和光照稳定性方面的重要功能。

(c.ii) 若对所有帧都进行重打光处理作为输入,虽然FID分数略有提升(达到71.10),但这主要是因为输入更接近逐帧IC-Light的标准参考。然而,这种做法会大幅增加计算开销,并破坏帧间的连续性。因此,这也从反面印证了仅对单帧进行重打光的设计在效率与效果上的平衡优势。

论文结论与评价

总结

Light-X首次提出了一种能够对单目视频实现相机视角与光照联合控制的生成框架,标志着可控视频生成领域的一项重要突破。其核心贡献在于设计了一个有效的解耦机制——通过动态点云分别承载几何结构与光照信息,从而将原本复杂的多因素控制问题转化为可管理的子任务。此外,借助创新的Light-Syn数据合成流程,模型得以在丰富多样的训练样本上进行优化,在联合控制和视频重打光两项任务中均展现出优于现有方法的性能表现。这一工作不仅提升了生成质量,也为影视特效、虚拟现实及数字内容创作等实际应用场景提供了强有力的技术支持。

优点

- 框架创新性强:首次实现了对相机视角与光照的同步调控,填补了当前技术体系中的关键空白。

- 方法设计巧妙:采用双点云机制分离几何与光照信息,逻辑清晰且结构合理;同时,Light-Syn数据生成管线具有高度创造性,有效缓解了真实数据稀缺的问题。

- 性能表现优越:在定量指标与主观视觉评估中,Light-X均表现出色,具备高保真度、良好的时间连贯性以及精准的控制能力。

缺点

- 依赖上游模型:模型效果受制于所使用的单图像重打光模型(如IC-Light)和深度估计模块的质量,若这些前置工具表现不佳,则误差会逐级传递,影响最终输出。

- 几何表示的局限性:基于点云的表达方式在面对大范围相机运动(例如360度旋转)或严重遮挡场景时容易出现点云稀疏问题,进而导致重建质量下降。

- 计算成本较高:作为基于扩散模型的方法,其推理过程需进行多步去噪,导致计算负担较重,目前尚难以满足实时生成的需求。

扫码加好友,拉您进群

扫码加好友,拉您进群