一、学习动因:在数据洪流中探寻底层技术根基

初次接触 Hadoop 源于一场行业技术交流会,当时“全球 90% 大型企业的核心数据引擎”这一描述立刻引起了我的关注。尽管彼时 AI 与云计算正成为热议焦点,周围许多从业者纷纷聚焦于实时计算框架和大模型应用,我却不禁产生疑问:为何一个诞生超过十年的技术体系,依然能在大数据领域占据不可替代的地位?正是这份好奇驱使我放弃零散的知识积累,转而选择一条系统化、由理论到实践的学习路径——从研读官方文档起步,结合实战课程训练,逐步完成从单机模拟到集群部署的过渡,深入探索 Hadoop 的内在机制。

随着理解不断加深,我逐渐认识到,Hadoop 的持久生命力并不依赖于“前沿”或“新颖”,而在于其对海量数据存储与处理本质问题的精准回应。其核心理念——“化整为零”的分布式思想,不仅是支撑其长期发展的技术基石,也成为我在后续学习中最关键的认知突破。这种思维方式不仅适用于工程架构,在面对复杂业务挑战时,也引导我建立起“拆解—协同—落地”的系统性解决逻辑。

二、核心收获:贯通技术原理与实际应用的关键脉络

1. 技术认知跃迁:从组件记忆迈向体系构建

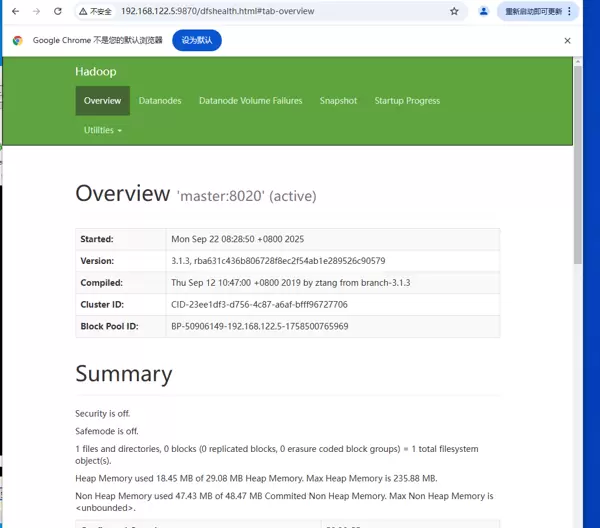

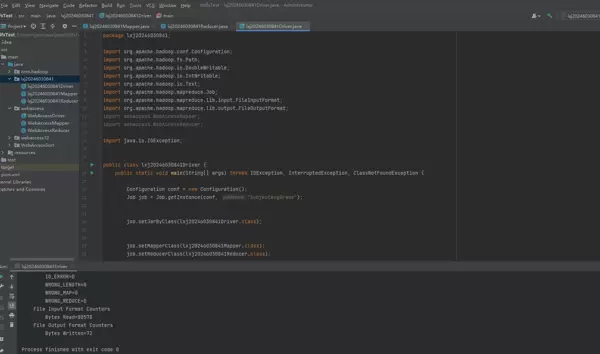

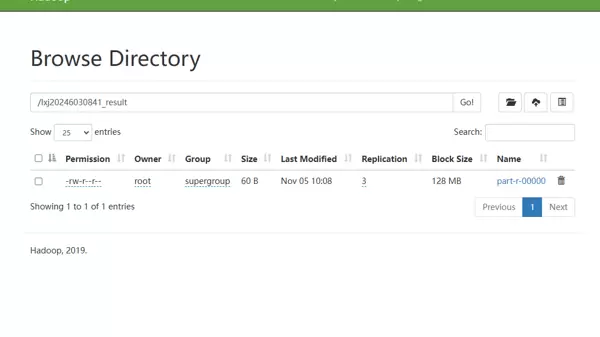

初学阶段,我曾陷入机械记忆组件功能的误区:能够熟练背诵 HDFS 是分布式文件系统、MapReduce 是并行计算框架,但当被追问“为何 HDFS 默认块大小设定为 128MB?”“Shuffle 阶段具体完成了哪些操作?”时,却难以清晰作答。真正的转折点出现在我使用 Docker 搭建伪分布式环境,并亲手执行首个 WordCount 程序的过程中。看着本地文件上传至 HDFS,经历 Map 阶段的数据切分与统计,再通过 Reduce 阶段聚合输出结果,整个流程以可视化方式呈现,我才真正理解各模块之间的协作机制。

HDFS 扮演的是“超大规模存储中心”的角色,其设计远不止简单的文件分割存储。128MB 的块大小是综合考量磁盘 IO 效率与寻址开销后的最优平衡;三副本策略则在保障数据可靠性的同时控制了存储成本。作为计算引擎的 MapReduce,其 Shuffle 过程中的排序、分区与合并操作,是确保中间数据高效流转的核心环节。YARN 则如同系统的“资源调度中枢”,ResourceManager 与 NodeManager 协同工作,实现 CPU 与内存资源的动态分配。例如,当我同时提交 MapReduce 和 Hive 查询任务时,YARN 会根据优先级与资源需求自动协调,避免资源冲突导致性能下降。

生态组件的丰富进一步强化了 Hadoop 的整合能力。在一次用户行为分析项目中,我利用 Flume 实时采集用户的点击流与停留日志并写入 HDFS,随后通过 MapReduce 完成数据清洗(如去重、格式标准化),接着借助 Hive 建立外部表,用 SQL 语句挖掘“不同年龄段用户偏好的内容类型”,最终将分析结果导入 Tableau 实现可视化展示。整套流程无缝衔接,让我深刻体会到 Hadoop 作为一体化数据平台的强大优势。

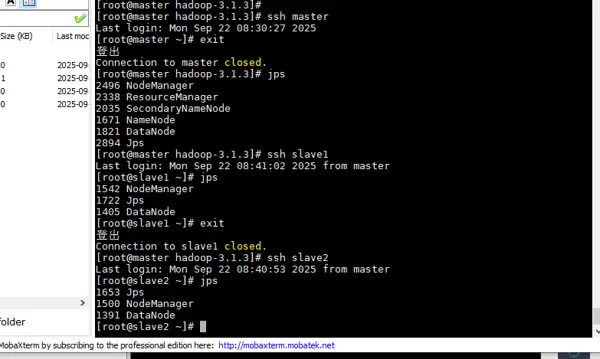

2. 实践能力进阶:从环境配置走向业务赋能

在整个学习过程中,我始终坚持“以实战为核心”的原则,严格遵循入门指南推进每一步。前期花费约一个月时间巩固基础技能:重新梳理 Linux Shell 命令(包括批量文件处理与环境变量设置),补充 Java 多线程及 IO 流知识(以便理解 Hadoop 底层实现),并加强 SQL 复杂查询能力(为后续 Hive 使用打下基础)。

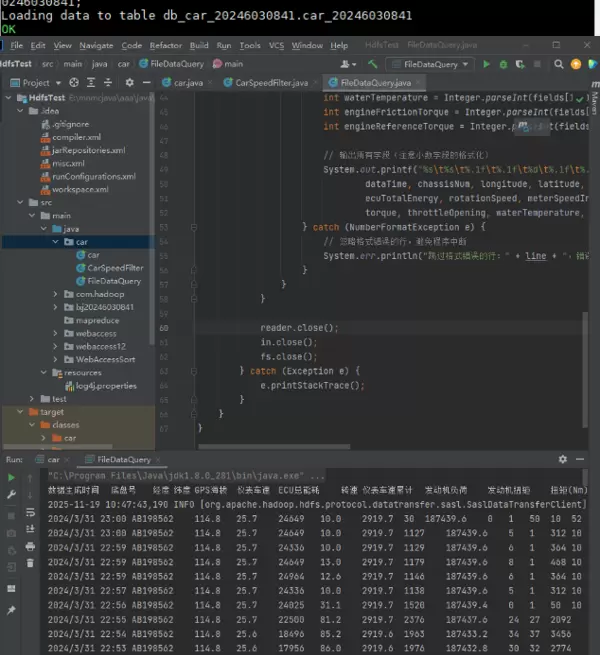

在基础夯实之后,并未直接挑战复杂的原生集群搭建,而是采用 Docker 快速构建伪分布式环境。通过编写 Docker-Compose 脚本,一键启动 NameNode、DataNode、ResourceManager 等关键服务,有效规避了因操作系统差异或依赖包版本不兼容带来的部署难题,使我能够集中精力钻研核心技术本身。技术的意义,终究体现在它能否解决真实场景中的问题。

3. 思维模式革新:突破单机局限,拥抱分布式逻辑

Hadoop 不仅提升了我的技术实操能力,更重要的是引发了思维方式的根本转变。在此之前,我的数据处理思路始终局限于“单机范式”——一旦数据量增长,第一反应往往是“提升服务器硬件配置”或“优化代码执行效率”。然而,学习 Hadoop 后我才意识到,当数据规模达到 TB 甚至 PB 级别时,单机性能的提升已远远无法满足需求。真正的突破口在于分布式架构所倡导的“拆分与协同”思维:将大任务分解为小单元,并行处理后再汇总结果,从而实现横向扩展的能力跃升。

在学习 Hadoop 的过程中,我深刻体会到“分而治之”这一核心思想的强大之处。以电商双 11 的场景为例:面对高达 10PB 的用户行为数据(相当于 5000 万部高清电影),若使用单机处理可能需要数月时间,而借助 Hadoop 集群则仅需数小时即可完成分析。其背后的技术逻辑在于,HDFS 将大文件切分为多个小数据块,并分布存储于不同节点;MapReduce 则将计算任务拆解为多个 Map 子任务,在数据所在节点本地执行——实现“移动计算而非移动数据”,最后通过 Reduce 阶段汇总结果。

这种架构设计让我逐步建立起从整体到局部的系统性思维。在后续参与一个大型日志分析项目时,我不再执着于“如何提升单台服务器性能”,而是转向思考“任务如何合理拆分”“资源如何高效分配”“如何避免数据倾斜”等更本质的问题。思维方式的转变,使我在应对复杂业务需求时更加从容且高效。

三、成长沉淀:技术之外的能力跃迁

1. 问题解决能力的提升

Hadoop 的学习过程,本质上是一次深度的问题排查与解决训练。从环境搭建到实际项目部署,我曾遇到多种典型问题:例如集群节点之间通信失败,经排查发现是防火墙未关闭或 SSH 免密登录配置有误;MapReduce 任务运行超时,查看日志后确认为 YARN 资源不足(默认内存设置偏低),通过调整 yarn-site.xml 中的 yarn.nodemanager.resource.memory-mb 参数后恢复正常;又如 Hive 查询提示“列不存在”,最终查明原因为建表时指定的字段分隔符与实际数据文件不符(数据用逗号分隔,但表定义使用了制表符),重新建表并正确指定分隔符后问题得以解决。

这些实践经历帮助我形成了一套行之有效的问题处理流程:首先依据日志精准定位错误源头(Hadoop 各组件的日志详细记录了运行状态和异常信息);其次查阅官方文档及社区资源(如 Apache Hadoop 官网、Stack Overflow)获取解决方案;最后通过小范围测试验证修改效果,避免盲目更改配置引发新问题。我逐渐认识到,掌握大数据技术的关键不仅在于“会用工具”,更在于“能否独立解决问题”。企业在招聘时真正看重的,往往是技术人员面对故障时的分析与恢复能力,而非单纯的编码熟练度。

2. 行业视野的拓展

原文中列举的三大行业应用案例,使我跳脱出单纯的技术视角,开始关注 Hadoop 在真实业务中的价值体现。在互联网领域,它是支撑用户行为分析与个性化推荐系统的数据底座;在运维场景中,可用于海量日志分析,实现系统异常检测与故障预警;在金融行业,则广泛应用于交易数据分析,助力风控建模与信用评估。

此外,我也了解到 Hadoop 在政务、医疗、交通等多个领域的深入应用:政府部门利用它处理人口普查数据,优化公共资源布局;医疗机构借助其分析电子病历与基因组数据,推动疾病预测与新药研发。这些实例让我意识到,技术的终极目标是服务于业务需求。

如今我能更清晰地理解企业为何普遍选择 Hadoop 作为离线大数据处理的核心平台:一是其生态成熟稳定,经过十余年发展,兼容性强,支持几乎所有主流数据格式;二是部署成本低,可在普通 x86 服务器上构建集群,无需依赖昂贵的专业硬件;三是具备近乎无限的扩展能力,HDFS 支持通过横向扩容节点实现 PB 级乃至 EB 级的数据存储。这种对行业痛点的理解,也促使我对职业发展方向有了更明确的认知:未来的大数据人才,必须兼具技术功底与业务洞察力,才能真正发挥数据的价值。

四、未来展望:在持续实践中深化技术应用

经过这段时间的学习,我已系统掌握了 Hadoop 的核心技术组件(包括 HDFS、MapReduce、YARN)以及常用生态工具(如 Hive、HBase、Flume)的使用方法。更重要的是,这段经历坚定了我在大数据领域长期深耕的决心。

正如原文所述,当前 Hadoop 正朝着“云原生化”与“实时化”方向演进。接下来,我将重点投入两个方向的学习:其一,研究 Hadoop 与主流云平台的集成方案,如 AWS EMR 和阿里云 E-MapReduce,掌握弹性集群的部署、监控与管理技能,以适应企业向云端迁移的趋势;其二,深入学习 Hadoop 与 Spark、Flink 等实时计算框架的协同应用,弥补传统 MapReduce 在延迟方面的不足,构建融合“离线批处理 + 实时流处理”的全链路数据处理体系。

同时,我将持续参与实战项目锻炼综合能力。计划启动“城市交通流量分析”项目:使用 Flume 采集交通摄像头产生的日志数据,存入 HDFS;再分别利用 MapReduce 进行历史数据统计,Spark Streaming 实现实时流量监测,最终输出交通热力图与拥堵预警报告。此外,我还打算积极参与开源社区,通过提交代码补丁、修复 Bug 等方式,提升自身技术水平与团队协作能力,在实践中不断打磨专业素养。

在大数据时代,数据已成为至关重要的核心资产。Hadoop 作为处理海量信息的基石技术,为我开启了进入大数据领域的关键通道。通过这段学习历程,我深刻体会到,掌握技术没有捷径可走,必须将理论知识与实际操作紧密结合,才能真正理解其内在逻辑,并充分释放技术的应用价值。

同时,我也认识到技术更新迭代的速度极快,唯有保持持续学习的态度,不断吸收新知,才能在飞速发展的行业中保持竞争力。面向未来,我将带着这些收获与思考,继续深入探索大数据相关技术,不断提升自身能力,在数据驱动的时代浪潮中坚定前行。

扫码加好友,拉您进群

扫码加好友,拉您进群