关注前沿科技 量子位 2022-11-02 17:52 发表于北京

学废一位人类插画师,AI只用了32张作品。

故事的主人公叫做Hollie Mengert(霍姐),她自打2011年从艺校毕业以来就从事着插画相关工作。

11年来的打拼,也让霍姐在插画上有了自己独树一帜的风格。

然鹅……

有天霍姐一觉醒来却收到朋友的来信:“姐~你现在成人家AI的模型了”。

于是乎,毫不知情的霍姐便去Reddit上看了看到底是咋回事,结果——

有位小哥搞了个AI,只用了霍姐32张作品训练,就能模仿她的风格作画!

△左:霍姐作品;右:AI作品

好了,这下子大家都能用这个AI,画出霍姐风格的插画了。

而且更“致命”的是,给AI输入的提示词必须带上“holliemengert artstyle”(霍姐风)……

(多冒昧啊……)

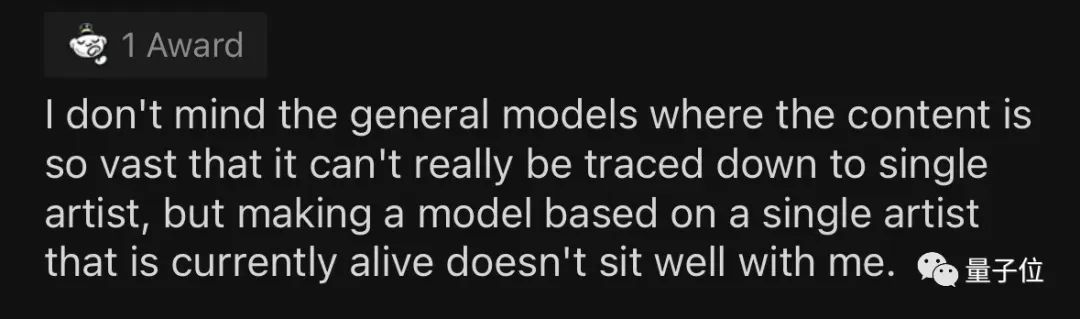

这波操作也是直接让网友炸了锅,纷纷留言为霍姐抱不平:

人家还活着呢……

你可把这位姐妹坑惨了。

然后随着这事的逐渐发酵,细节也逐渐浮出了水面。

2.5小时炼出新模型,成本不到15块事情最初只是一位来自加拿大的工程师Ogbogu Kalu(卡哥),出于个人爱好做了个插画AI。

看着效果还不错,他就把模型发到了Reddit上,结果一下子火了!

不少网友看了直呼:这是巨作!

本以为需要成千上万张图才能训练出好的效果,没想到这么点儿也可以。

而且训练成本也很低,卡哥说自己做这个模型,只是在云端租了GPU、花2个半小时就搞定了。

折算成本不到2美元(人民币约15块)。

不过,卡哥当时做出这个AI也实属意外,在此之前他并不了解霍姐的作品。选择这一风格,只是因为他在帮别的网友微调模型,那位网友给出的风格和霍姐画风相似。

通过改进数据集,他一晚上便弄出了一个效果更好的新模型,命名为“hollie-mengert-artstyle”。并把代码也放了出来,人人都能免费试玩。

他用到的AI,主要是Stable Diffusion和DreamBooth。

后者是模仿风格精髓的关键。

这是谷歌在今年8月发布的新AI。它只需3-5张图片,再加上文字表述,就能让指定物体迁移到其他场景或风格中去。

和Dall-E 2、Imagen等最大的不同是,DreamBooth能对选定对象忠实还原。

具体方法是给物体加上“特殊标识符”。

原本图像生成模型收到的指令只是一类物体,例如[cat]、[dog]等,但现在DreamBooth会在这类物体前加上一个特殊标识符,变成[V][物体类别]。

以下图为例,将用户上传的三张狗子照片和相应的类名(如“狗”)作为输入信息,得到一个经过微调的文本-图像扩散模型。

该扩散模型用“a [V] dog”来特指用户上传图片中的狗子,再把其带入文字描述中,生成特定的图像,其中[V]就是那个特殊标识符。

而且这种方法不局限于某个模型,Dall-E 2、Stable Diffusion等调整后也能实现如上效果。

比如之前亚马逊工程师就发布过一个DreamBooth-Stable-Diffusion。

Hugging Face上这类模型超级多,各种风格都有,如迪士尼、赛博朋克等等。

卡哥的模型也属于其中之一。

实际上,把DreamBooth用在Stable Diffusion不算难,油管就有现成教程。

有人用30张图微调模型,全程不到20分钟,并且效果是杠杠好,他的照片可以毫不违和地融入到各种风格中去。

(不过芝麻街这个很难判断效果到底好不好 )

)

扫码加好友,拉您进群

扫码加好友,拉您进群