随着大模型技术的快速演进,单一智能体架构在应对复杂业务场景时逐渐显现出局限性。多智能体协同开发因此成为推动AI应用落地的关键方向。在众多可用框架中,LangGraph、Autogen与Crewai凭借差异化的架构设计和强大的工具集成能力脱颖而出,广泛受到开发者青睐。尽管三者均聚焦于多智能体系统构建,但在核心定位、协作机制、工具整合方式及适用场景方面各具特色。本文将从实际开发角度出发,深入剖析三者的功能特性,助力开发者根据项目需求做出更精准的技术选型。

早期AI应用多依赖单个智能体完成特定任务,如文本生成或问答服务。然而,面对日益复杂的现实场景,这种“单打独斗”模式暴露出诸多问题:难以处理多阶段流程、缺乏动态响应机制、工具调用逻辑固化等。而多智能体框架通过模拟人类团队的分工协作机制,将复杂任务分解为多个子任务,并由不同角色的智能体并行或串行处理,显著提升了系统的灵活性与实用性。

一个高效的多智能体系统需解决三大关键挑战:首先是智能体间的协作机制,确保任务分配合理且信息传递顺畅;其次是对外部工具的支持能力,便于接入搜索、数据库、API等资源以扩展功能边界;最后是流程编排的灵活性,支持根据运行状态动态调整执行路径。LangGraph、Autogen和Crewai正是围绕这些核心问题发展出各自独特的技术路线,形成了风格迥异的设计哲学。

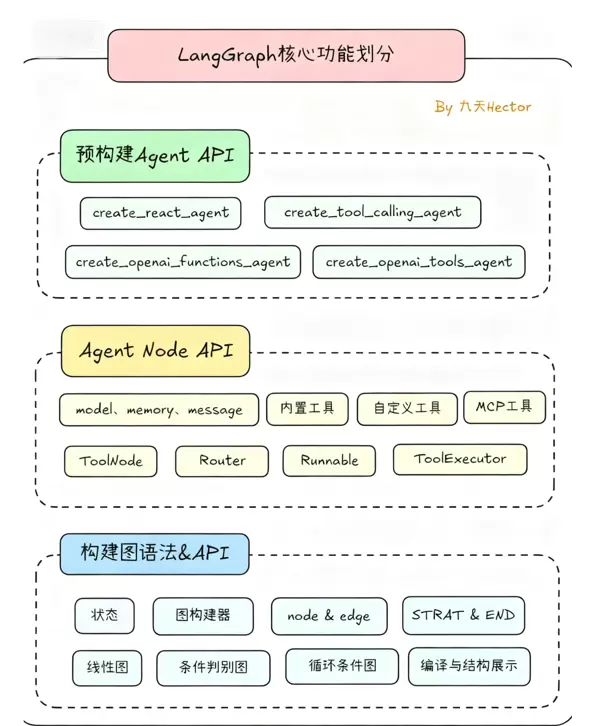

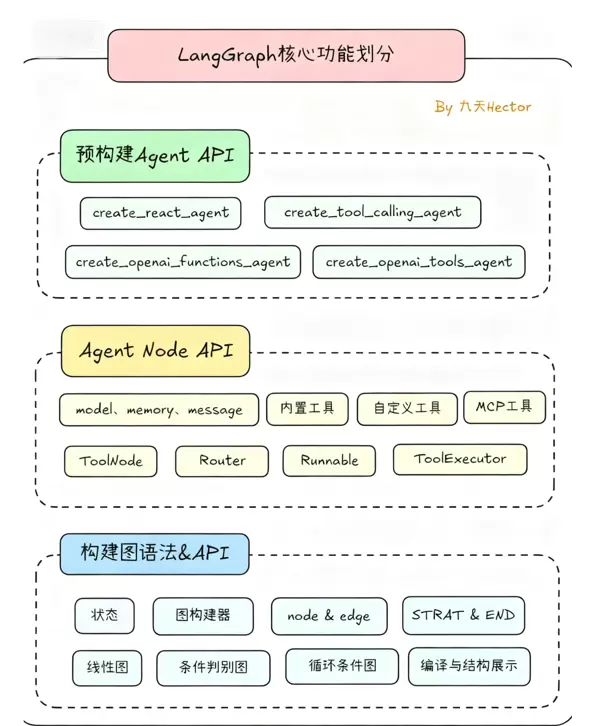

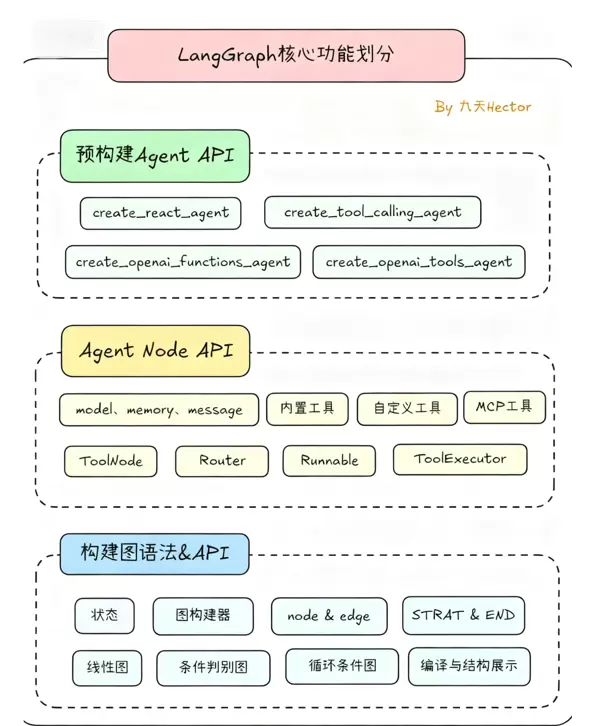

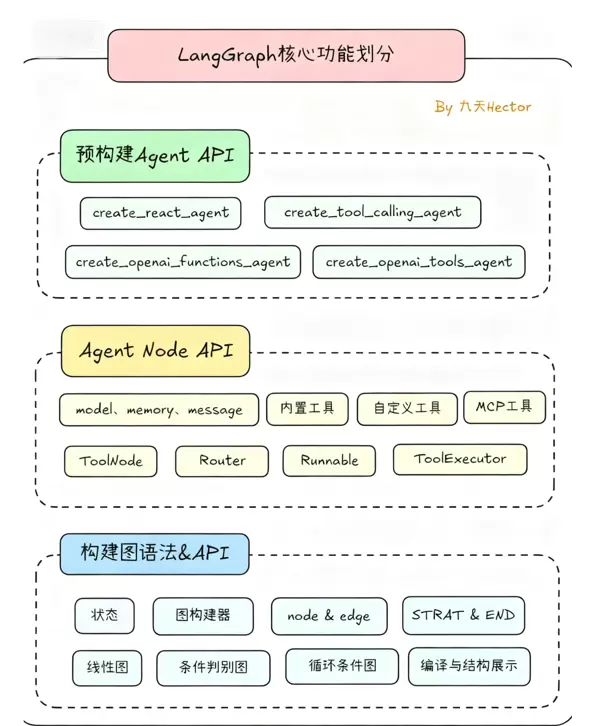

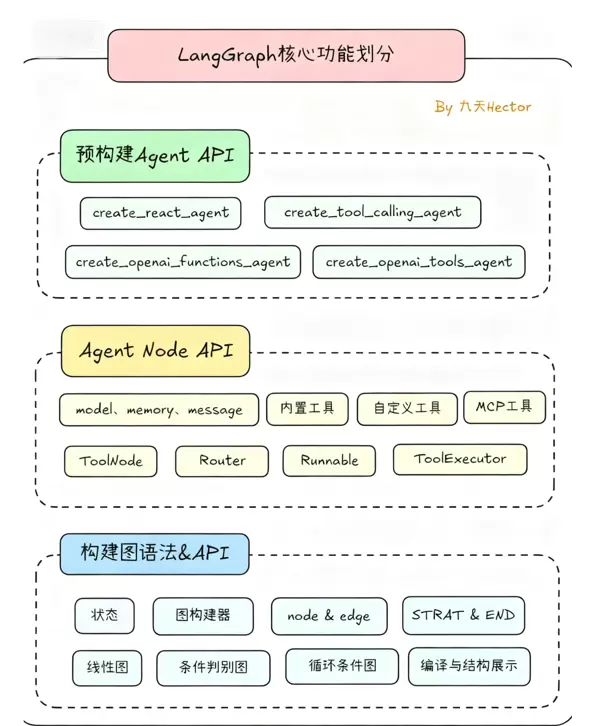

作为LangChain生态体系中的高级扩展,LangGraph专注于提供灵活的任务流程控制能力。其设计理念强调“以有向图定义工作流,以状态驱动节点流转”。相较于传统线性链式结构,LangGraph采用图状拓扑(包含循环与条件分支),每个节点可代表一个智能体、工具调用或决策判断,边则表示流转规则。整个流程通过共享的状态对象(State)记录中间数据和上下文信息,实现对复杂逻辑的精确掌控。

由于继承自LangChain,LangGraph天然兼容其模型接口、工具库以及表达式语言(LCEL),可视作LangChain在流程管理方面的增强版本。对于已有LangChain使用经验的开发者而言,迁移到LangGraph几乎无需学习成本,同时还能获得更强的流程定制能力。

LangGraph本身不独立构建工具集,而是全面依托LangChain多年积累的丰富组件库。这其中包括网络搜索工具(如Tavily、SerpAPI)、向量数据库(如Chroma、Pinecone)、代码解释器(Python REPL、SQL执行)、办公自动化接口(Excel、Slack)等数百种常用模块。开发者可直接将这些工具封装为图中的执行节点,避免重复造轮子。

此外,框架还支持MCP(多智能体协作协议)与A2A(跨智能体通信协议),能够轻松对接外部系统或其他智能体平台,进一步拓宽工具覆盖范围。例如,在构建自适应RAG系统时,可结合Chroma进行文档检索,利用Tavily补充实时网页信息,并通过图结构实现“检索→评估→优化”的闭环迭代流程。

LangGraph的核心优势体现在其强大的状态管理机制与条件路由功能。状态是一个可自定义的结构化字典,用于存储任务执行过程中的所有关键信息(如原始输入、中间结果、用户反馈等)。所有节点均可读取或更新该状态,保障了信息在整个流程中的高效流通。

条件路由则允许根据当前状态内容动态决定下一步走向。例如,在RAG流程中,可通过判断检索结果的相关性来触发不同分支:若匹配度高,则进入答案生成环节;否则跳转至问题重写模块,重新发起检索。此类机制使LangGraph特别适合处理需要反复迭代、多路分支判断的复杂任务,如智能数据分析、动态决策系统等。

为降低企业级应用的开发门槛,LangGraph提供了一整套配套工具:

前端对话界面支持多轮交互、文件上传以及工具调用过程的可视化展示,能够无缝对接后端LangGraph服务,便于快速构建产品原型。

由于LangGraph在架构设计上的灵活性,它特别适用于处理流程较为复杂且需要根据运行时状态进行动态调整的业务场景。典型应用包括:

以下为使用LangGraph实现“检索—评估—生成”闭环逻辑的核心代码片段,展示了其强大的工具集成与流程编排能力:

import os

from langchain_openai import ChatOpenAI

from langchain_community.vectorstores import Chroma

from langchain_community.tools.tavily_search import TavilySearchResults

from langgraph.graph import StateGraph, START, END

from typing_extensions import TypedDict

from typing import List

# 定义工作流状态结构

class GraphState(TypedDict):

question: str

generation: str

documents: List[str]

# 初始化模型与工具组件

embedding = OpenAIEmbeddings(model="text-embedding-3-small")

vectorstore = Chroma.from_documents(documents=doc_splits, embedding=embedding)

retriever = vectorstore.as_retriever()

web_search = TavilySearchResults(max_results=1)

llm = ChatOpenAI(model="gpt-4o-mini", temperature=0)

# 构建各节点处理函数(即具体工具调用逻辑)

def retrieve(state):

"""执行文档检索操作"""

print("---执行文档检索---")

return {

"documents": retriever.get_relevant_documents(state["question"]),

"question": state["question"]

}

def grade_documents(state):

"""对检索结果进行相关性评分与过滤"""

print("---评估文档相关性---")

filtered_docs = [

doc for doc in state["documents"]

if retrieval_grader.invoke({

"question": state["question"],

"document": doc.page_content

}).binary_score == "yes"

]

return {

"documents": filtered_docs,

"question": state["question"]

}

def generate(state):

"""基于上下文生成最终回答"""

print("---生成回答---")

generation = rag_chain.invoke({

"context": state["documents"],

"question": state["question"]

})

return {

"documents": state["documents"],

"question": state["question"],

"generation": generation

}

# 路由决策函数:判断是否需重新查询

def decide_to_generate(state):

"""若存在有效文档则进入生成阶段,否则触发查询优化"""

return "generate" if state["documents"] else "transform_query"

# 创建状态图并注册各个节点

workflow = StateGraph(GraphState)

workflow.add_node("retrieve", retrieve)

workflow.add_node("grade_documents", grade_documents)

workflow.add_node("generate", generate)

workflow.add_node("transform_query", transform_query)

# 定义节点流转规则

workflow.add_edge(START, "retrieve")

workflow.add_edge("retrieve", "grade_documents")

workflow.add_conditional_edges("grade_documents", decide_to_generate, {"generate": "generate", "transform_query": "transform_query"})

workflow.add_edge("transform_query", "retrieve")

workflow.add_conditional_edges("generate", grade_generation, {"useful": END, "not useful": "transform_query"})

# 编译并运行

app = workflow.compile()

for output in app.stream({"question": "payment_backend服务是谁维护的?"}):

for key, value in output.items():

print(f"节点 '{key}' 执行完成")

Autogen由微软研究院推出,其设计核心是“以对话为中心”,致力于简化多个智能体之间的协作流程。与强调流程编排的LangGraph不同,Autogen无需开发者手动构建复杂的工作流结构,而是通过智能体间的自然语言对话实现任务分配和工具调用。

开发者仅需设定每个智能体的角色(如研究员、分析员、执行者)及其能力范围(例如可使用的工具),系统便会自动处理沟通逻辑,涵盖任务分解、信息传递以及冲突协调等环节。

该框架的目标是“让非专业开发人员也能快速构建多智能体系统”。为此,Autogen在功能设计上聚焦于降低使用门槛,强调开箱即用与低代码开发体验。

Autogen提供了极为简洁的工具接入方式。开发者只需将所需功能封装为Python函数,并通过特定参数将其绑定至智能体,即可实现工具调用。该框架兼容多种类型工具,包括本地函数、外部API接口及命令行程序,无需额外适配层。

function_map以下示例展示了如何将Tavily搜索服务集成到智能体中:

def tavily_search(query):

import tavily

client = tavily.TavilyClient(api_key=os.getenv("TAVILY_API_KEY"))

return client.search(query=query, max_results=3)["results"]

# 将工具绑定至智能体

assistant = autogen.AssistantAgent(

name="assistant",

llm_config={"model": "gpt-4o", "api_key": os.getenv("OPENAI_API_KEY")},

function_map={"tavily_search": tavily_search}

)

此外,Autogen支持工具的动态调用和参数自动填充。智能体可根据当前任务需求自主判断是否调用工具、选择哪个工具以及如何配置参数,整个过程无需开发者预先编写调用指令。

Autogen的核心优势在于其强大的对话驱动协作引擎,具备以下关键能力:

例如,在执行市场调研任务时,Autogen会自动将整体任务划分为“数据收集”(调用搜索引擎)、“数据分析”(运行Python脚本)和“报告生成”三个阶段,分别由不同的智能体完成,并通过对话机制同步进展与结果。

Autogen提供了一系列高度可复用的智能体模板,如AssistantAgent(通用助手)、UserProxyAgent(用户代理)和GroupChat(群组协作)等,开发者可直接调用这些模板快速搭建协作系统。

同时,系统支持通过配置文件定义智能体的角色设定、能力范围及协作规则,大幅减少编码工作量,提升开发效率。

以下是一个利用GroupChat实现多智能体协同的代码示例:

为了实现多智能体之间的高效协作,首先需要定义用户代理智能体,该智能体负责接收初始输入并触发后续任务执行流程。以下是用户代理的配置:

user_proxy = autogen.UserProxyAgent(

name="user_proxy",

human_input_mode="NEVER", # 完全自动化运行,无需人工干预

max_consecutive_auto_reply=10,

code_execution_config={"use_docker": False}

)

接下来,构建两个专业角色智能体:市场调研专家与数据分析师。每个智能体具备特定功能和工具调用权限。

此智能体专注于信息搜集工作,利用外部搜索工具获取行业动态和市场数据。

researcher = autogen.AssistantAgent(

name="researcher",

llm_config={"model": "gpt-4o", "api_key": os.getenv("OPENAI_API_KEY")},

function_map={"tavily_search": tavily_search},

system_message="你是市场调研专家,负责收集行业数据"

)

该智能体负责处理结构化或非结构化数据,进行计算、建模与结果解读。

analyst = autogen.AssistantAgent(

name="analyst",

llm_config={"model": "gpt-4o", "api_key": os.getenv("OPENAI_API_KEY")},

function_map={"python": autogen.code_utils.execute_python},

system_message="你是数据分析师,负责处理和解读调研数据"

)

通过 GroupChat 将多个智能体组织成一个协作小组,并由 GroupChatManager 担任协调者,控制对话轮次与流程走向。

groupchat = autogen.GroupChat(agents=[user_proxy, researcher, analyst], messages=[], max_round=50)

manager = autogen.GroupChatManager(groupchat=groupchat, llm_config={"model": "gpt-4o", "api_key": os.getenv("OPENAI_API_KEY")})

启动整个协作流程的指令如下:

user_proxy.initiate_chat(manager, message="分析2024年中国AI行业融资趋势")

Autogen 的架构设计特别适用于以下几类任务场景:

Autogen 的主要优势在于“低代码”特性与高效的协作能力,显著降低了构建多智能体系统的门槛,使开发者能更专注于核心业务逻辑的设计,而非底层通信与调度机制。

然而,其也存在若干限制:

Crewai 的设计哲学聚焦于“角色化分工”与“流程自动化”,将多智能体系统视作一个具备明确岗位职责的专业团队。每个智能体被赋予具体身份(例如产品经理、工程师、设计师),并配有相应职责、技能与目标。系统通过预设任务链(Task)推动整体协作进程。

相较于 LangGraph 的图状流程编排模式以及 Autogen 的对话驱动机制,Crewai 更强调“角色—任务—流程”三者的绑定关系,在确保执行规范性的同时保留足够的灵活性。

Crewai 支持为不同智能体配置专属工具集,确保工具使用与其职能高度匹配。例如:

其工具集成方式简洁直观,既兼容 LangChain 提供的丰富工具库(因两者有深度整合),也可扩展自定义功能模块。示例代码如下:

from crewai import Agent, Task, Crew

from langchain_community.tools import TavilySearchResults, PythonREPLTool

# 定义基础工具

search_tool = TavilySearchResults(max_results=3)

code_tool = PythonREPLTool()

# 创建智能体并绑定对应工具

function_map(2)核心工具:任务链与流程管理机制

Crewai 的关键组件包括 Task 和 Crew,二者共同构建了自动化任务执行的框架:

以下为构建“新能源汽车行业报告”自动生成流程的示例代码:

# 定义任务 task1 = Task( description="搜索2024年新能源汽车行业销量、增长率、头部企业市场份额数据", expected_output="包含关键数据的结构化文档", agent=research_agent ) task2 = Task( description="使用Python分析收集到的数据,生成销量趋势图和市场份额饼图", expected_output="数据分析代码、可视化图表、关键趋势总结", agent=analysis_agent, dependencies=[task1] # 依赖任务1的结果 ) task3 = Task( description="根据数据分析结果,撰写行业报告,包含市场现状、趋势预测和建议", expected_output="结构化的行业分析报告(Markdown格式)", agent=report_agent, dependencies=[task2] ) # 创建团队并执行流程 crew = Crew( agents=[research_agent, analysis_agent, report_agent], tasks=[task1, task2, task3], process="sequential" # 按顺序执行任务 ) # 启动任务 result = crew.kickoff() print(result)

(3)协作机制:基于目标的角色协同体系

Crewai 中的智能体协作围绕明确的任务目标展开,每个 Agent 专注于自身职责范围内的任务,信息通过任务间的依赖关系自动流转。例如,当 research_agent 完成数据采集后,analysis_agent 可自动获取其输出结果进行后续分析,无需开发者手动实现数据传递逻辑。此外,Crewai 支持设定“团队领袖”(Crew Leader),该角色可协调整体进度、监控异常情况并介入处理突发问题,从而提升多智能体系统的运行效率与稳定性。

3. 典型应用场景

得益于其结构化流程设计与角色分工机制,Crewai 特别适用于以下几类场景:

4. 工具优势与局限性分析

Crewai 的主要优势体现在“结构化流程 + 角色化分工”的设计理念上,能够保障任务执行过程的规范性与输出质量的一致性,尤其适合企业级、流程明确的业务应用。然而,其也存在一定的局限:

五、三大框架工具特性横向对比

为了帮助开发者更直观地理解各框架之间的差异,以下从核心设计思想、工具集成能力、协作模式、开发门槛及适用场景等多个维度进行综合比较:

1. 核心设计理念对比

2. 工具集成能力

LangGraph 提供强大的外部工具接入能力,允许在节点中调用任意函数或 API,并结合记忆机制与条件跳转实现复杂行为控制,便于与数据库、搜索引擎、第三方服务等深度集成。

在多智能体系统开发中,LangGraph、Autogen与Crewai作为主流框架,各自具备不同的工具集成能力、协作模式、开发门槛及扩展特性。以下从多个维度进行对比分析,帮助开发者根据项目需求做出合理选择。

Crewai:深度整合LangChain的工具库,支持将特定工具绑定到具体角色,实现职责与功能的高度匹配。虽然工具复用性较强,但在扩展灵活性方面略逊于LangGraph。

LangGraph:依托LangChain生态体系,提供数百种工具支持,兼容MCP/A2A协议,具备极强的工具复用性和组合能力,适用于复杂工具链的构建与调度;

Autogen:工具接入方式简洁,可直接集成Python函数、API接口和命令行工具,无需额外适配逻辑。但其工具种类依赖开发者自定义或第三方支持,整体生态相对有限。

LangGraph:采用节点化架构,通过图结构与状态机管理实现智能体与工具之间的有序调用。协作流程清晰可控,适合需要精确控制执行路径的场景;

function_mapCrewai:基于任务驱动的协作模式,依据任务依赖关系和角色分工推进工作流,流程规范严谨,适用于结构化程度高的业务场景;

Autogen:以自然语言对话为核心,智能体之间通过自由交流分配任务、传递信息,协作过程灵活开放,无需预设固定流程,适合动态协商型任务。

LangGraph:开发门槛中等偏高,需掌握图结构设计与状态管理机制,建议具备LangChain使用经验的团队选用;

Crewai:属于中等难度,要求开发者能明确定义角色职责与任务流程,适合熟悉实际业务逻辑的团队;

Autogen:入门简单,无需复杂流程建模,只需配置智能体与工具即可快速启动,非常适合初学者或希望快速验证想法的轻量级项目。

LangGraph:得益于LangChain生态支撑,系统运行稳定,支持复杂流程编排和多工具联动,具备良好的扩展能力,广泛应用于企业级系统;

Crewai:流程结构化设计降低了出错概率,稳定性高,扩展性适中,适用于流程固定的组织级应用;

Autogen:稳定性一般,对复杂流程支持较弱,扩展受限,更适合轻量化应用和原型验证阶段。

选择合适的框架应综合考虑任务类型、流程复杂度、团队技术背景等因素。以下是针对不同场景的具体推荐:

LangGraph、Autogen和Crewai分别代表了三种典型的多智能体开发范式:LangGraph侧重“灵活编排”,适用于复杂流程与企业级系统;Autogen强调“零代码协作”,利于快速构建原型;Crewai聚焦“结构化分工”,适用于专业性强、流程规范的任务场景。

随着技术演进,三大框架正不断优化自身短板:LangGraph将进一步提升图结构的可视化能力,降低使用门槛;Autogen将增强流程控制力,支持更复杂的协作逻辑;Crewai则计划引入更多对话式交互机制,提高流程灵活性。

未来多智能体框架的发展方向将是“灵活性、规范性与易用性”的融合——既能应对复杂多变的任务流程,又能保障执行效率与一致性,同时兼顾开发便捷性,推动AI智能体系统向更高效、更可靠的方向发展。

扫码加好友,拉您进群

扫码加好友,拉您进群

收藏

收藏