当前,气候变化已成为全球共同面临的重大挑战,深刻影响着农业体系、自然生态系统、水资源分布、人类健康以及社会经济结构。科学研究证实,自工业革命以来,人类活动引发的温室气体排放与全球气温升高、极端天气频发、冰川退缩及海平面上升等现象存在显著关联。为科学评估并有效应对这一趋势,气候科学家构建了全球气候模型(GCM),这类复杂的数值系统通过数学方程模拟大气、海洋、陆面、冰雪圈和生物地球化学过程之间的相互作用。

世界气候研究计划(WCRP)主导的气候模型比较计划(CMIP)为多模型对比提供了标准化平台,使研究人员能够系统评估不同模型的表现力、一致性及其不确定性来源。目前广泛使用的CMIP6在空间分辨率、物理机制描述以及地球系统组件耦合方面相较前代CMIP5实现了重要突破。与此同时,人工智能技术特别是大语言模型(LLM)与深度学习的发展,正为气候科学带来前所未有的变革机遇。从数据预处理到模式识别,从降尺度分析到极端事件预测,AI正在全面渗透至气候研究的核心环节。

全球气候模型基于流体力学、热力学和辐射传输理论,采用离散化方法求解控制地球气候系统的偏微分方程组。其核心模块包括大气环流模型、海洋环流模型、陆面过程、海冰动力与热力学模块以及碳循环等生物地球化学过程。随着计算能力提升,现代GCM已实现更高时空分辨率,并引入更精细的云微物理参数化方案。

然而,模型的空间与时间分辨率仍存在局限,导致局部气候特征难以精确捕捉,同时参数化方案的选择也带来了显著的预测不确定性。因此,理解这些误差来源对于合理解读模拟结果至关重要。

CMIP由WCRP发起,旨在协调国际主要气候中心开展统一实验设计,促进模型间可比性。CMIP6作为最新一代框架,设置了更为丰富的实验情景,涵盖历史模拟、未来路径(如SSP1-2.6、SSP5-8.5)、敏感性试验和地球工程模拟等。

相较于CMIP5,CMIP6增强了复杂地球系统模型(ESM)的应用,整合了动态植被、气溶胶-云相互作用、氮循环等更完整的反馈机制。此外,它提供了更多模式成员和更高的输出频率,支持对极端气候事件进行精细化分析。研究者可根据具体课题选择合适的模式组合与共享社会经济路径(SSP),以提高结果的代表性与稳健性。

除CMIP外,多个专项比较计划进一步拓展了气候建模的研究维度:

这些计划不仅提升了模型可信度,也为政策制定提供了关键科学依据。各项目数据可通过公开门户获取,遵循相应的使用规范即可用于学术研究。

近年来,大语言模型(LLM)如ChatGPT、GPT-4、Gemini、DeepSeek、Claude等快速发展,展现出强大的语义理解与生成能力。在气候领域,LLM可用于快速解析海量文献、辅助撰写科研文档、生成代码片段或解释复杂算法逻辑。

同时,机器学习技术已在多个方向展现优势:

LLM正在逐步嵌入科研工作流,例如:

借助工具如ChatGPT、DeepSeek等,研究人员可大幅提升工作效率,降低编程门槛,实现“人机协同”的新型研究模式。

CMIP6数据主要通过地球系统网格联合会(ESGF)分布式节点发布。用户需注册账号、认证权限后,在指定门户界面按模型、变量、情景和时间范围筛选所需数据集,并手动触发下载任务。虽然操作直观,但效率较低,适合小规模数据获取。

为提高效率,可采用以下自动化手段:

利用开源工具如esgf-download,可在终端中通过配置JSON参数文件实现多文件并发下载,显著提升数据获取速度,尤其适用于大规模数据请求。

通过向LLM输入清晰的任务描述(如“编写一个Python脚本,从ESGF下载CMIP6中BCC-CSM2-MR模型的tas变量在historical情景下的数据”),可获得结构完整、语法正确的爬虫代码框架,再经适当调整即可运行。

部分ESGF节点支持“购物车”功能,允许用户先添加所需数据至列表,随后统一提交请求并跟踪下载进度。该方式兼顾灵活性与可控性,适合跨多个节点的数据整合任务。

Python凭借其丰富的科学计算库成为气候数据分析主流语言。掌握基本语法与常用库是后续高级处理的前提。

本节回顾适用于气候研究的Python核心语法,并强调如何利用AI工具提升编码效率。

关键科学计算库的深入应用包括:

netCDF是气候模型输出的标准格式,具备自描述性和多维存储特性。熟练掌握其读写操作至关重要。

netCDF4或xarray库读取变量、属性与维度信息;selvar);sellonlatbox);timmean、ymonmean);remapbil)。结合大语言模型,可将自然语言指令转化为精确的CDO命令,例如:“将CMIP6的降水数据重网格到1°×1°并计算年均值”,直接输出对应命令链。

针对非标准日历(如BCC模型使用的365天/年日历),需特别注意时间维度对齐问题,避免日期错位。

Xarray为带标签的多维数组提供类Pandas的操作体验,极大简化了netCDF数据的分析流程。

DataArray(单变量)与Dataset(多变量集合);典型应用场景包括:

构建高效的AI增强型数据处理流程应包含以下环节:

通过Python脚本串联上述步骤,并借助AI持续优化逻辑结构与性能表现,形成可复用的分析管道。

基于TensorFlow、PyTorch等主流框架,研究人员可构建专用AI模型解决特定气候问题:

结合迁移学习策略,可在有限样本条件下提升模型泛化能力,推动AI在区域气候影响评估中的实际落地。

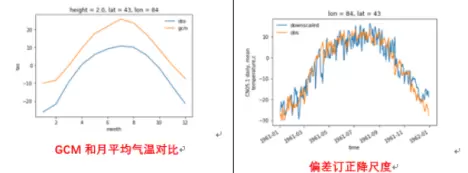

降尺度技术在气候研究中具有重要意义,能够将全球气候模型(GCM)输出的粗分辨率数据转化为区域高分辨率信息。该过程有助于提升区域气候变化评估的精度。

经典Delta方法是一种广泛使用的统计降尺度手段,其核心在于利用历史观测数据与模拟数据之间的偏差,对未来的模拟结果进行修正。该方法包括温度和降水变量的未来趋势预测,具备计算简便、物理意义明确等优点。

通过引入人工智能技术,可实现Delta方法的智能化升级。例如,开发自动化脚本完成多站点、长时间序列的批量处理,并结合机器学习优化偏差校正流程。实际应用案例显示,AI增强后的Delta方法在区域气候预测中表现出更高的稳定性和准确性。

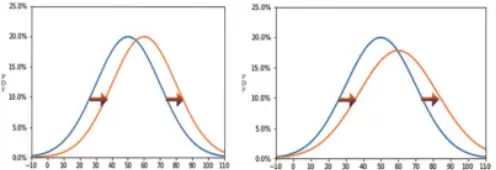

概率分布函数(PDF)订正是气候数据降尺度中的关键环节,旨在调整模型输出的分布特征以匹配观测数据的统计特性。该方法特别适用于非线性偏差明显的变量,如降水。

在区域尺度上,PDF订正技术常采用分位数映射策略,通过建立模型与观测之间的分位数对应关系,实现精细化校准。传统方法依赖人工设定参数,效率较低。

借助AI技术,可以实现订正方案的自动构建。例如,利用神经网络学习最优映射函数,或使用强化学习动态调整映射策略。AI驱动的分位数映射显著提升了订正效果,尤其在极端事件再现方面表现突出。

案例研究表明,在区域降水降尺度任务中,融合AI的PDF订正方法有效改善了降水频率和强度的模拟性能。

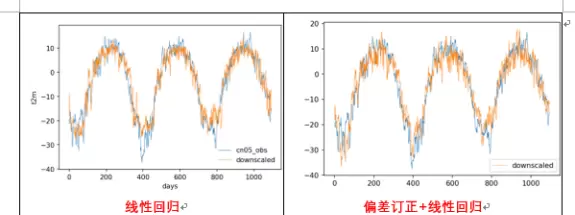

传统机器学习方法在空间降尺度中展现出强大潜力。典型流程包括特征工程、模型训练与验证三个阶段。常用模型有随机森林和XGBoost,它们对非线性关系建模能力强,且具备一定的可解释性。

通过AI辅助进行特征选择和超参数调优,可进一步提升模型性能。例如,采用遗传算法或贝叶斯优化搜索最佳参数组合,提高预测精度。

卷积神经网络(CNN)因其强大的空间特征提取能力,被广泛应用于气候数据的空间降尺度任务中。通过设计适合气候场结构的CNN架构,能够有效恢复小尺度空间细节。

超分辨率卷积神经网络(SRCNN)在气候数据重构中取得良好效果,可用于温度、降水等变量的高分辨率重建。此外,借助大语言模型辅助编写训练代码、调试模型结构,显著降低了深度学习应用门槛。

生成对抗网络(GAN)被用于生成高分辨率气候场,其生成器负责构造精细结构,判别器则监督生成质量。该方法在保持空间连续性的同时,能捕捉复杂的地理地形影响。

Transformer模型凭借其对长时序依赖的建模能力,在时间序列降尺度任务中表现出色。它可用于将低频气候输出转换为日尺度甚至小时尺度的变化序列。

典型案例包括:基于深度学习的温度数据降尺度,实现了城市尺度下的热环境模拟;针对降水极端事件的高分辨率重构,增强了对短时强降水的识别能力;以及多变量协同降尺度技术,同步提升多个气候要素的空间一致性。

多模型集成是降低单一模型偏差的有效策略。通过融合不同算法的预测结果,可提升整体鲁棒性和泛化能力。AI在此过程中可用于设计集成框架并优化权重分配。

基于AI的集成方法支持动态加权机制,根据各模型在不同区域或时段的表现自适应调整贡献比例。此外,贝叶斯模型为不确定性量化提供了理论支撑。

利用PyMC、Stan等贝叶斯推断工具,可构建概率性降尺度模型,输出不仅包含预测值,还包括置信区间。此类方法有助于全面评估降尺度结果的可靠性。

最终,结合可解释性AI技术,如SHAP值分析或注意力机制,可深入解析模型决策依据,并在实际案例中验证其科学合理性。

动力降尺度依托区域气候模型(如WRF),在有限区域内以更高分辨率模拟大气过程。相比统计方法,其优势在于物理机制完整,但计算成本较高。

WRF模型具备灵活的配置选项,适用于多种地理和气候条件下的区域模拟。其核心模块涵盖微物理、边界层、辐射等多个物理过程方案。

为驱动WRF运行,需将CMIP6等全球模式输出数据转换为合适的输入格式。此过程通常借助CDO工具处理GCM数据,涉及压力坐标系或sigma坐标系的转换操作。

WPS(WRF Preprocessing System)负责地理数据插值与初始场构建。通过AI辅助,可自动化完成路径配置、域设置及数据预检,大幅提升准备效率。

WRF模式的执行包括namelist配置、并行运行与结果输出等步骤。合理设置物理参数方案对模拟精度至关重要。

开展敏感性分析有助于识别关键参数的影响程度。AI技术可用于指导参数优化,例如通过代理模型快速评估不同组合的效果,减少试错成本。

后处理阶段涉及变量提取、统计分析与可视化。借助Python脚本与Xarray库,可高效处理大量netCDF文件。AI还可辅助异常检测、模式识别与结果归纳,提升分析效率。

传统生物地球化学(BGC)模型虽机理清晰,但计算复杂度高。通过融合AI技术,可在不牺牲精度的前提下显著提升运算效率。

主要改进方向包括:利用机器学习替代耗时的过程模块(如光合作用响应函数)、通过AI优化模型参数、以及采用集成学习降低系统性偏差。

在碳通量预测方面,基于CMIP6数据驱动的区域碳循环模拟已广泛开展。研究涵盖草地生态系统在极端干旱下的响应机制,以及湿地碳排放与气候反馈的动态关系。

蒸散发是水循环的关键环节。AI驱动的深度学习模型(如LSTM、GRU)在估算日尺度蒸散发方面优于传统经验公式,尤其在异质地表条件下表现更佳。

通过融合遥感、气象站与再分析数据,可实现多源信息融合,进一步提升预测精度。同时,区域差异性分析揭示了不同气候区的响应特征。

对于极端降水事件,AI可用于检测变化信号并归因于人为或自然因素。结合不同SSP情景,可评估未来洪涝风险演变趋势。深度学习模型还能捕捉降水模式的长期转移特征。

热指数预测对城市规划和建筑设计至关重要。AI模型可结合气象与城市形态数据,预测人体舒适度与热胁迫风险。

微气候模拟借助AI实现快速推演,支持高密度城区的局部温度预测。采暖与制冷度日数的AI建模则有助于预估建筑能耗变化。

通过多时间尺度预测(季节至多年),可为节能设计提供差异化参考,体现区域适应性策略的重要性。

从CMIP6数据中提取气候极值指数是评估极端事件变化的基础。常见温度类指数包括热浪日数、霜冻日数和生长季长度;降水类指数涵盖连续干日、强降水日数及95百分位降水量。

标准化干旱指数(如SPI、SPEI、PDSI)用于衡量水分盈亏状态,支持跨区域比较。这些指数可通过Python结合Xarray库高效实现。

编程实现主要包括:基于固定阈值或动态分位数识别极端事件,利用滑动窗口检测持续性事件(如持续高温或干旱)。

多模式集合分析可揭示不同GCM在极端事件预测上的共性与分歧。通过对模式间结果的统计对比,评估预测可信度。

重点分析内容包括:极端事件频率的变化趋势、强度随SSP情景的演变、以及空间分布格局的迁移。

热点区域识别技术帮助锁定高风险地带。主成分分析(PCA)可用于提取极端事件空间模态,并解释其物理成因。

分类算法在极端事件识别中发挥重要作用。随机森林可用于挖掘极端事件发生前的关键前兆信号;支持向量机则擅长区分不同类型极端天气。

聚类分析(如K-means、DBSCAN)有助于发现极端事件的空间聚集模式,揭示潜在的大气环流背景。

在时间序列预测方面,LSTM网络被成功应用于极端温度事件的提前预警;简单神经网络也可用于降水极值的趋势外推,为防灾减灾提供支持。

AI模型在气候数据分析中扮演日益重要的角色。TensorFlow与PyTorch作为主流深度学习框架,支持从数据加载到模型部署的全流程开发。

深度学习广泛应用于气候变量预测与模式识别任务,如气温趋势预测、降水分类、气候分区划分等。模型通常结合时空特征进行联合建模。

完整的气候AI分析流程包含以下环节:

面对海量气候数据,高效的计算架构至关重要。Python生态提供了多种并行处理工具:

Python可视化工具在气候分析中不可或缺:

AI技术也被用于增强可视化可解释性,例如自动生成图表标题、注释关键变化点或推荐最优图表类型。

netCDF是气候数据的标准存储格式。使用xarray进行I/O操作可高效管理多维数组,支持分块读取、坐标索引与元数据保留。

最佳实践包括:合理设置chunk大小以平衡内存与速度、使用压缩减少文件体积、确保单位与坐标信息完整记录。

借助AI工具链,研究人员可快速搭建端到端的气候分析流水线。从数据预处理、特征构建、模型训练到结果输出,均可实现自动化调度与监控,极大提升科研效率。

在极端事件的模式识别与分析过程中,降维技术发挥着至关重要的作用。高维数据往往包含大量冗余信息和噪声,直接进行建模或可视化处理难度较大。通过引入有效的降维方法,可以在保留关键特征的前提下,显著降低数据的复杂度,从而提升模式提取的效率与准确性。

常用的技术手段包括主成分分析(PCA)、t-分布邻域嵌入(t-SNE)以及线性判别分析(LDA)等。这些方法能够将原始高维空间中的数据映射到低维子空间中,同时尽可能地保持样本之间的结构关系。例如,PCA通过寻找方差最大的方向进行投影,有效捕捉数据的主要变化趋势;而t-SNE则更擅长于保留局部邻近关系,在可视化极端事件聚类结构方面表现突出。

在气象、金融、地震等领域的极端事件研究中,降维不仅有助于发现潜在的异常模式,还能为后续的分类、聚类和预测模型提供高质量的输入特征。此外,结合非线性流形学习方法,如等距映射(Isomap)和局部线性嵌入(LLE),可以进一步提升对复杂非线性结构的表达能力。

值得注意的是,不同降维方法对数据分布假设和参数设置较为敏感,因此在实际应用中需根据具体场景选择合适算法,并辅以交叉验证等手段评估其有效性。总体而言,合理运用降维技术,能够显著增强极端事件中隐含模式的可解释性与可探测性。

扫码加好友,拉您进群

扫码加好友,拉您进群

收藏

收藏