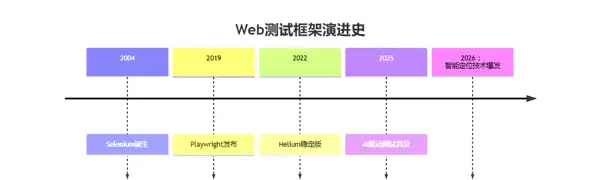

在软件测试领域飞速发展的背景下,自动化工具的选取成为影响项目成败与团队效率的关键因素。不当的选型可能使团队陷入长期维护旧脚本、处理兼容性难题或无法有效覆盖现代Web应用核心功能的困境。数据显示,约35%的自动化测试项目延期可归因于工具选择失误。本文将从专业测试视角出发,深入剖析Selenium、Playwright和Helium三大主流框架在2026年的技术演进趋势、适用场景及常见风险应对策略。

一、核心技术能力对比分析

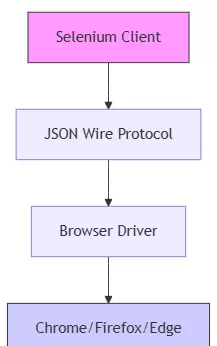

1. Selenium:行业基石的持续演化

架构特性:基于WebDriver协议构建,支持跨浏览器测试,广泛兼容Java、Python、C#等主流编程语言。

核心优势:

- 生态成熟度高:超过80%的企业级测试系统依赖Selenium实现自动化

- 社区资源丰富:Stack Overflow上累计超47万条相关讨论,问题解决路径清晰

- 云端集成能力强:无缝对接Sauce Labs、BrowserStack等主流云测平台

2026年面临的技术瓶颈:

- 对现代单页应用(SPA)的动态响应支持有限

- 异步操作需手动设置等待逻辑,导致脚本稳定性下降

- 移动端测试必须借助Appium扩展,增加架构复杂性

2. Playwright:面向未来的现代化解决方案

关键技术突破:

- 内置自动等待机制,避免人为插入sleep语句

- 统一API支持Chromium、Firefox、WebKit三大内核

- 原生提供设备模拟与触摸事件仿真能力

性能表现(依据2025年行业基准测试数据):

- 执行速度较Selenium提升2.1倍

- 脚本运行可靠性提高65%

- 并行测试时资源占用减少40%

典型应用场景:

- 敏捷开发中快速覆盖Chromium系浏览器

- 微前端架构下的复杂交互流程验证

- 视觉回归测试与网络请求拦截分析

3. Helium:极简主义的轻量级选择

设计理念:在Selenium基础上封装高层API,聚焦于提升测试脚本编写效率与可读性。

主要优势:

- 语法简洁,代码量比传统Selenium减少约60%

- 学习门槛低,新手工程师可在两天内掌握基础使用方法

现存局限:

- 自定义扩展能力不足,难以满足复杂业务需求

- 与企业级CI/CD流水线集成存在较高实施难度

- 对非标准UI组件的支持较为薄弱

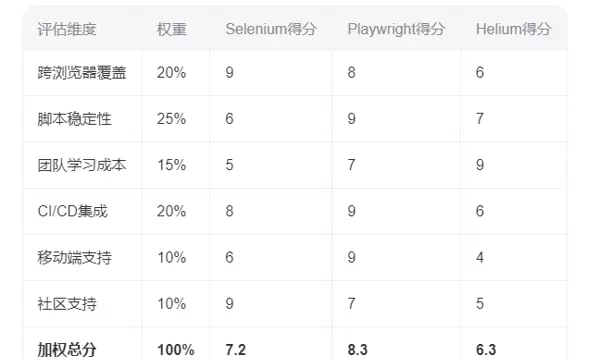

二、实际项目中的选型决策模型

采用加权评分法建立科学评估体系,结合具体业务特征进行综合判断。

典型场景推荐方案

大型金融系统测试

推荐配置:Selenium + 自定义增强框架

选择理由:需与历史系统深度对接,且满足严格审计要求,成熟稳定的生态系统更具保障。

电商大促活动验证

推荐配置:Playwright + 视觉对比工具链

选择理由:面对高频迭代需求,精准的交互验证与UI一致性检测尤为重要。

内部管理后台回归测试

推荐配置:Helium + 数据驱动测试架构

选择理由:标准化流程下,优先考虑脚本的易维护性与开发效率。

三、团队技术升级实施路径

采取分阶段推进策略,确保平稳过渡与可持续发展。

第一阶段:现状调研与评估(1–2周)

- 盘点现有测试资产,识别技术债务

- 明确各业务模块自动化优先级

- 组建3至5人的概念验证小组

第二阶段:技术可行性验证(2–4周)

- 并行运行相同测试用例,横向比较三种工具表现

- 量化评估开发效率、执行稳定性及后期维护成本

- 形成技术选型建议报告并提交管理层审批

第三阶段:渐进式迁移计划(按季度推进)

- Q1:搭建新框架基础设施,完成核心成员培训

- Q2:迁移关键业务路径测试用例,建立效能基线

- Q3:全面推广落地,沉淀最佳实践案例库

- Q4:建立反馈闭环机制,推动持续优化改进

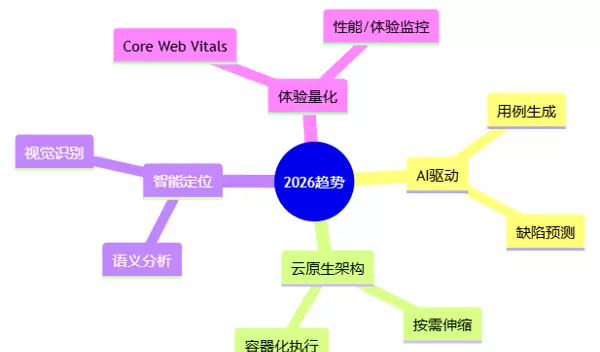

四、2026年测试技术发展趋势展望

- AI辅助测试生成:依托GPT-4o等大模型实现用例自动生成,预计可提升测试覆盖率40%以上

- 云原生测试架构:容器化部署测试环境将成为行业标配

- 智能元素定位策略:视觉定位与语义理解逐步替代传统的CSS/XPath选择器

- 性能与用户体验融合:Core Web Vitals指标正式纳入自动化校验体系

结语

各类测试工具并无绝对优劣之分,关键在于是否契合团队技术储备与具体业务需求。建议每半年开展一次技术栈复盘,构建灵活可扩展的测试架构体系,防范因工具锁定引发的技术债务累积。进入2026年,真正具备竞争力的测试团队,将是那些能够在技术创新与落地能力之间达成最优平衡的组织。

扫码加好友,拉您进群

扫码加好友,拉您进群