如题,最近参加过某厂的比赛,自己公司一直在做二分类的问题,然后,无论从网上看到的案例还是kaggle的一些比赛里,大部分都用到了集成学习,比如bagging、boost,也用到stacking这样的方法来融合模型,都说效果很好。可是

本人也尝试了第一层构建LR/randomforest/SVM/knn/NB等算法,并以stacking方法融合生成了几个特征,第二层以xgboost构建最终的输出模型,发现效果跟直接在原特征上使用xgboost基本上差不离,甚至还略有下降,求各位有经验的大神来指点指点讨论,谢谢!

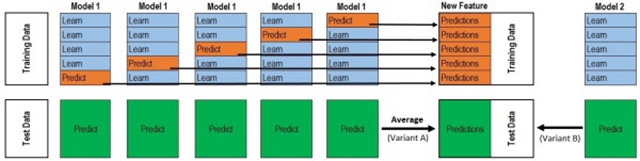

附本人使用的stacking方法原理文章及基本框架图:

Kaggle机器学习

Kaggle机器学习之模型融合(stacking)心得

扫码加好友,拉您进群

扫码加好友,拉您进群